最近AI概念股进入了调整期,但我们关于AI的研究还得接着做。

之前用神经元的基本结构和大家讨论过AI对于算力的消耗是怎么来的。

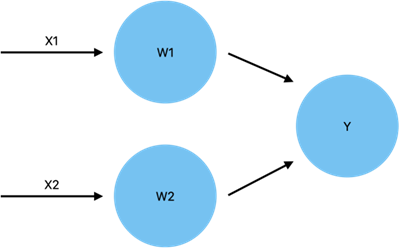

x1和x2代表外界刺激,也就是输入变量,经过神经元的处理也就是W1和W2的作用,得到输出结果Y。所谓的模型训练,就是通过给定多组Y和X去修正W,从而使得神经网络能够具备给出符合给定训练数据内在逻辑的输出能力,也称之为学习。期间,W越多,神经网络单次运算所需计算的乘法和加法次数越多,同时W越多也就意味着修正W的难度也越大,修正的难度也对应着训练次数的增加,也会成倍数地增加加法和乘法的运算次数,所以神经网络中计算机的底层工作就是加法与乘法,而大量的加法和乘法也是消耗算力的原因。

上一篇由于篇幅原因没有展开,大家看完也许不会意识到,加法和乘法次数的增加对于计算量的需求弹性是完全不同的。这是因为计算机没法直接做乘法运算,得先把乘法转化成一定数量的加法。

当然,不同转换思路需要的计算量有所不用,比较笨拙的会将被乘数进行乘数次连续相加,这样一来,进行一次乘法需要的计算量就是加法的乘数倍。当然实际运算中也会有更高效的办法,但基本摆脱不了乘法与加法的计算量之间存在倍数量级的差异。换句话说,有那么多从加法入手的乘法要做,算力的消耗就没法变少。

为啥计算机做乘法就那么费劲呢?没办法,这是由二进制的计算框架以及基于二进制框架搭建的数字电路决定的。所以,除非另辟蹊径,否则有那么多乘法要处理,高算力的消耗难以避免。

当然,蹊径也不是没有。

物理世界中就存在天然的乘法计算器——电阻。我们都知道I=U/R,如果我们把U作为输入变量,I就是乘法的计算结果,而这里面的乘数就是1/R,你会发现,用这种方式我们并不需要将乘法转换成加法,且无论乘数和被乘数多大,都不影响计算速度。这样的转变将大幅加速神经网络的计算效率,对算力的需求也大幅降低。

当然,这里面也有一些需要克服的问题,首先精度就是很重要的变量,电压的稳定、电流的测量、电阻值的精度都会影响输出结果。目前学术领域对这方面的研究仍在深入,也有人在实验室里实现了基于易阻器的神经网络模型训练。

回到投资,经常有人问,我们进行这样的学习和研究值不值得,我的答案是因人而异。对我来说研究完之后,虽然我并不能得出基于可变电阻的乘法计算电路很大概率会取代数字电路进行神经网络模型的训练的结论,但至少我知道了在什么情况下算力会是瓶颈,什么情况下能源会是瓶颈,以及什么情况下我们针对乘法的算力会极大的释放。这些对于我建立人工智能产业的行业常识很有帮助,而行业常识是价值评估中极其重要的前提变量。

$中泰兴诚价值一年持有混合A(OTCFUND|010728)$

$中泰兴诚价值一年持有混合A(OTCFUND|010728)$

以上观点仅代表当下观点,且不构成投资建议。

本文作者可以追加内容哦 !