弘信电子 | 燧弘华创助力庆阳东数西算,首个国产万卡算力集群启动

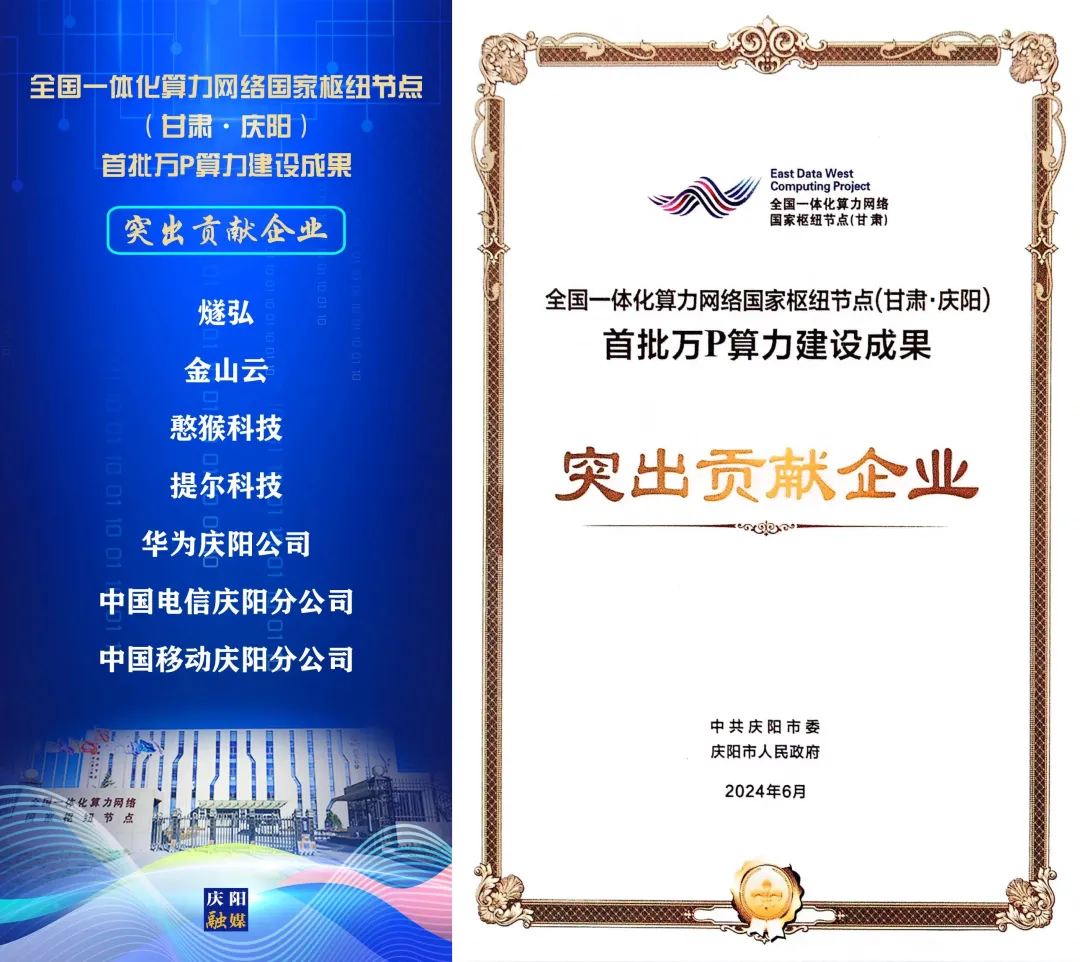

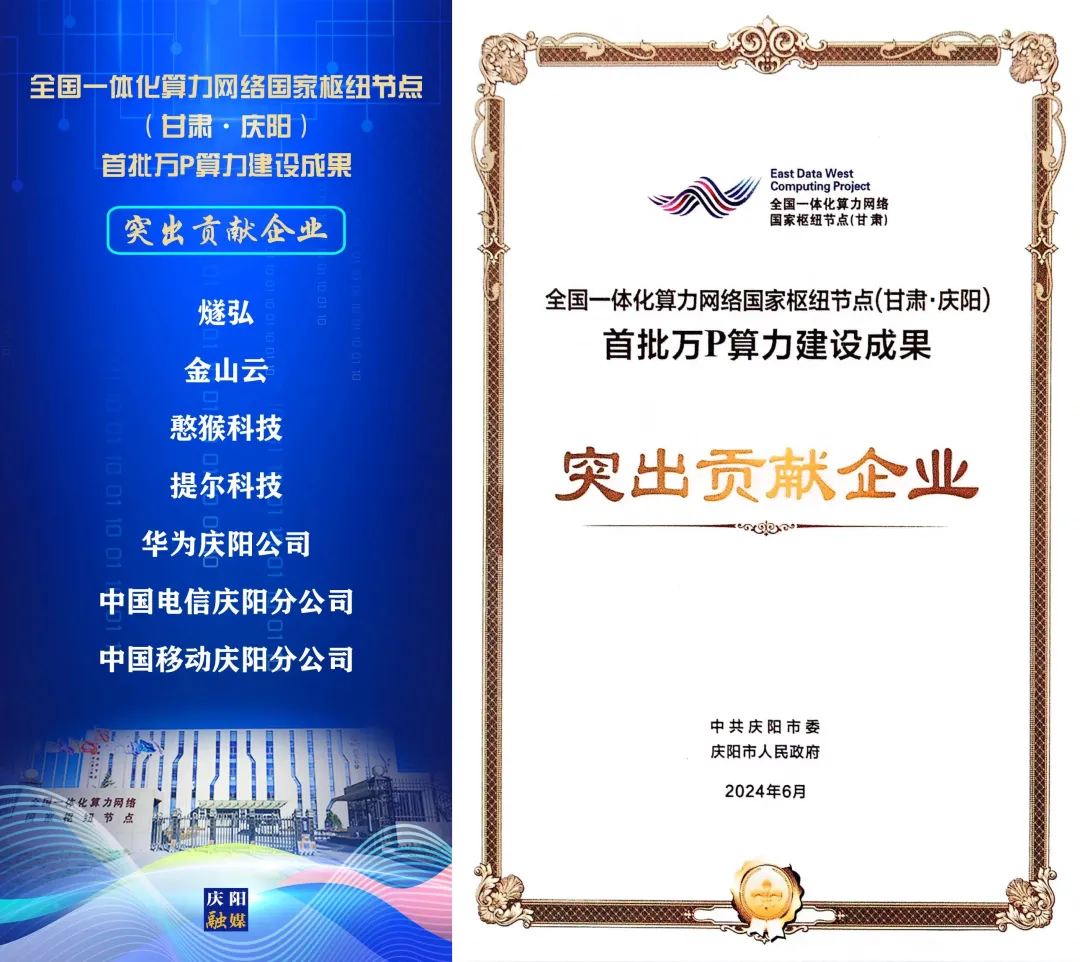

6月19日,全国一体化算力网络庆阳枢纽节点首批万P算力成功上线,首个国产万卡算力集群启动,首列东数西算“人才专列”开通。作为在庆阳率先部署国产算力集群的领军企业,燧弘华创凭借燧弘庆阳绿色智算中心,以及在庆阳市构建AI全产业链生态方面的显著成就,荣获“全国一体化算力网络国家枢纽节点(甘肃·庆阳)首批万P算力建设成果突出贡献企业”的殊荣。在启动仪式上,我们共同参与见证 “中国算谷·智慧庆阳”开启开启跨越发展、构建自主算力生态、招才引智的“新纪元”。

燧弘华创凭借在庆阳投建绿色算力产业及构建AI全产业链生态方面作出的重大贡献,在本批次受表彰企业名单中名列第一位。 算力是AI时代的核心生产要素,也是驱动新质生产力的基础能源。庆阳深刻把握人工智能时代算力发展脉搏,定位智算、链接智能、发展智产,加速推进10大绿色数据中心建设。目前已建成投运标准机架1.5万个,算力规模从去年底的5000P增加到1.2万P,庆阳数据中心集群建设跃上了新能级。未来,庆阳将持续扩大智算规模,今年底算力规模将达到5万P,明年底将达到10万P,为数字经济发展注入澎湃动力。

庆阳市委副书记、市长周继军介绍,“今天的首批万P算力成功上线,是‘中国算谷·智慧庆阳’跨越发展的重要里程碑,首个国产万卡算力集群启动,是庆阳构建自主算力生态的重要一步。我们将搭建‘高算力+高运力+高能效’产业平台,培育‘全域化+多元化+国产化’产业场景,构建‘大硬件+大模型+大数据’产业生态,加速建设‘中国算力高地’‘AI应用示范基地’‘AI产业链聚集地’。”

在启动仪式上,甘肃燧弘绿色算力有限公司执行总裁唐峰分享了燧弘华创在庆阳市构建AI全产业链生态的进展以及万卡国产化算力集群规划介绍。他强调,燧弘华创矢志不渝地致力于在甘肃省构建“高端算力服务器制造-智算中心建设-AI城市国产大模型绿色算力底座-千行百业算力消纳”的完整商业闭环和产业链生态的战略目标。这一战略目标,不仅将进一步释放数字经济高质量发展新动能,更持续领跑人工智能产业的创新发展,与甘肃省当前推产业转型升级、赋能科技创新进步的战略目标紧密相连。2023年10月28日燧弘华创与庆阳市政府正式签署战略合作协议,12月20日就点亮了开源开放、集约高效、绿色普惠的燧弘庆阳绿色智算中心,助力形成3000P的高性能算力供给规模,从而实现大规模混合异构算力历史性的突破,吹响庆阳打造中国最大智算枢纽节点的号角。依托燧弘华创助力部署的万卡千P燧原二代国产算力集群,建立了大规模国产算力适配中心,吸引众多知名大模型公司、云服务企业和互联网巨头进行深度适配和调优。经过半年多的不懈努力,这些工作取得显著成果,并为燧原三代万卡的国产绿色算力建设项目构筑稳固的基石。此外,我们还积极推动大模型训练等前沿技术在庆阳集群的部署,以吸引更多企业在甘肃庆阳形成大规模的算力消纳,为国产算力在推理端发力积蓄丰富的客户资源,为未来的发展奠定了坚实的基础。

唐总介绍,随着算力需求的暴涨,目前燧弘华创与生态伙伴在庆阳共同建设的7000P混合异构算力资源已无法满足市场的需求。为此,我们将在庆阳推出“多元混合异构算力系统”,旨在通过高性能算力吸引更多用户,引导他们聚集到庆阳。同时,我们将深入了解并满足算力用户的多样化需求,借助高校及大模型企业的丰富经验,逐步构建和完善国产算力生态,加速推动解决算力卡脖子难题,为中美博弈和中国AI产业快速崛起贡献力量。在庆阳市委市政府的大力支持下,我们将携手燧原科技,联合清华大学交叉院、兰州大学人工智能重点实验室等高校科研机构及人工智能领域相关企业,在庆阳共建万卡国产化算力集群项目。项目将以庆阳国产绿色算力大基座为基础,全面辐射北上深厦等人工智能领先地区,推动国产算力生态走向大规模现实运用。

庆阳市敏锐地把握住人工智能时代算力发展的脉搏,全力打造数字经济千亿级产业链。2023年布局算力产业以来,燧弘华创一直急速奔跑,在构建国产万卡算力集群及AI产业链生态方面取得重大突破及进展,公司将持续发力奋力前行,聚集更多的资源,引入更多的客户,投入更多的资金,助力庆阳构建更大更强更广的算力产业生态,打造成为全国AI产业标杆城市,不断激发数字经济高质量发展的澎湃动力,为中国算力事业及庆阳枢纽节点的建设注入更为强劲的动力与活力。

关于万卡集群

万卡集群是指由一万张及以上的加速卡(如GPU、TPU或其他专用AI加速芯片)组成的高性能计算系统,用以训练基础大模型。这种集群充分整合高性能GPU计算、高性能RDMA网络、高性能并行文件存储、智算平台等关键技术,将底层基础设施整合成为一台“超级计算机”,可支持千亿级甚至万亿级参数规模的大模型训练,有助于大幅压缩大模型训练时间,以实现模型能力的快速迭代。

以OpenAI训练GPT模型为例,GPT-4需要使用2.5万张英伟达A100 GPU,并行训练100天的左右时间,在此期间要处理13万亿个token,并且涉及大约1.76万亿个参数。在不久的将来,开发大模型所需的算力将实现指数级的增长,对于即将亮相的GPT-5,预计该模型的训练需要部署20万~30万个H100 GPU,耗时130~200天。万卡甚至超万卡智算集群将会成为未来智算中心的主要演进趋势,如何建设超万卡集群、如何充分发挥超万卡集群的性能与效率也将会是未来核心技术突破的重点。

郑重声明:用户在社区发表的所有信息将由本网站记录保存,仅代表作者个人观点,与本网站立场无关,不对您构成任何投资建议,据此操作风险自担。请勿相信代客理财、免费荐股和炒股培训等宣传内容,远离非法证券活动。请勿添加发言用户的手机号码、公众号、微博、微信及QQ等信息,谨防上当受骗!

郑重声明:东方财富网发布此信息的目的在于传播更多信息,与本站立场无关。东方财富网不保证该信息(包括但不限于文字、视频、音频、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关信息并未经过本网站证实,不对您构成任何投资建议,据此操作,风险自担。

燧弘华创凭借在庆阳投建绿色算力产业及构建AI全产业链生态方面作出的重大贡献,在本批次受表彰企业名单中名列第一位。 算力是AI时代的核心生产要素,也是驱动新质生产力的基础能源。庆阳深刻把握人工智能时代算力发展脉搏,定位智算、链接智能、发展智产,加速推进10大绿色数据中心建设。目前已建成投运标准机架1.5万个,算力规模从去年底的5000P增加到1.2万P,庆阳数据中心集群建设跃上了新能级。未来,庆阳将持续扩大智算规模,今年底算力规模将达到5万P,明年底将达到10万P,为数字经济发展注入澎湃动力。

燧弘华创凭借在庆阳投建绿色算力产业及构建AI全产业链生态方面作出的重大贡献,在本批次受表彰企业名单中名列第一位。 算力是AI时代的核心生产要素,也是驱动新质生产力的基础能源。庆阳深刻把握人工智能时代算力发展脉搏,定位智算、链接智能、发展智产,加速推进10大绿色数据中心建设。目前已建成投运标准机架1.5万个,算力规模从去年底的5000P增加到1.2万P,庆阳数据中心集群建设跃上了新能级。未来,庆阳将持续扩大智算规模,今年底算力规模将达到5万P,明年底将达到10万P,为数字经济发展注入澎湃动力。