1秒“穿越”,是一种怎样的体验?

在7月13日-7月16日举行的北京科博会现场

基于当虹BlackEye多模态视听大模型的

AIGC融合实景扩展技术

帮你实现1秒“穿越”

(北京市广电局党组书记、局长王杰群莅临当虹展位指导)

北京市广电局领导、CCTV-13、央视新闻客户端

都已经来打卡啦!

现场还有观众赞不绝口的AIGC视频短片

快来一起看看~

01 AIGC融合实景扩展 带你体验1秒“穿越”

当虹科技的展位,位于北京市广电局主办的“超高清视听科技展”区域。现场一个看似简单的空间,引来现场大朋友、小朋友们排队体验。

一走进这个空间,体验者瞬间就来到了一个装有落地窗的写字楼里,窗外还可以看到巍峨的雪山。转眼间,体验者又来到了充满书香的书房里,仿佛实现了1秒“穿越”。

(参观者现场体验一秒“穿越”)

现场工作人员介绍,这是基于BlackEye多模态视听大模型的AIGC融合实景扩展技术。

基于现场空间环境,大模型进行了特征提取和信息分析,然后根据输入的提示词或提示图,AI扩展出新的图片或者视频。

令现场观众惊叹的是,大模型生成的画面与现场场景实现了无缝融合,且能根据直播要求随时切换。

(央视多档节目关注当虹科技展台)

现场工作人员介绍,该技术区别于虚拟演播室蓝绿箱抠像,可以在实景中进行空间的扩展与融合,打破了演播室空间的限制,为有限的空间提供了无限的创意可能,真正实现了“小空间、大场景”的节目观感。

02 基于大模型的视频短片 体现出丰富理解力

在当虹科技展位上,一段表现江南四季之美的视频《江南·忆》,画面精美,景别丰富,引来许多观众的驻足与赞叹。

这段视频由BlackEye多模态视听大模型生成,不管是远景、近景还是特写,都体现出BlackEye对物理世界丰富的理解能力。

现场工作人员介绍,BlackEye融合了包括Transformer、Diffusion等在内的多种深度神经网络组件,深度整合了对文本、图像、视频和三维模型等跨模态内容的推理与生成能力,包括文本生成、文生视频、图生视频等生成式算法,以及AI视觉增强、AI横竖转换、AI智能集锦等分析式算法。

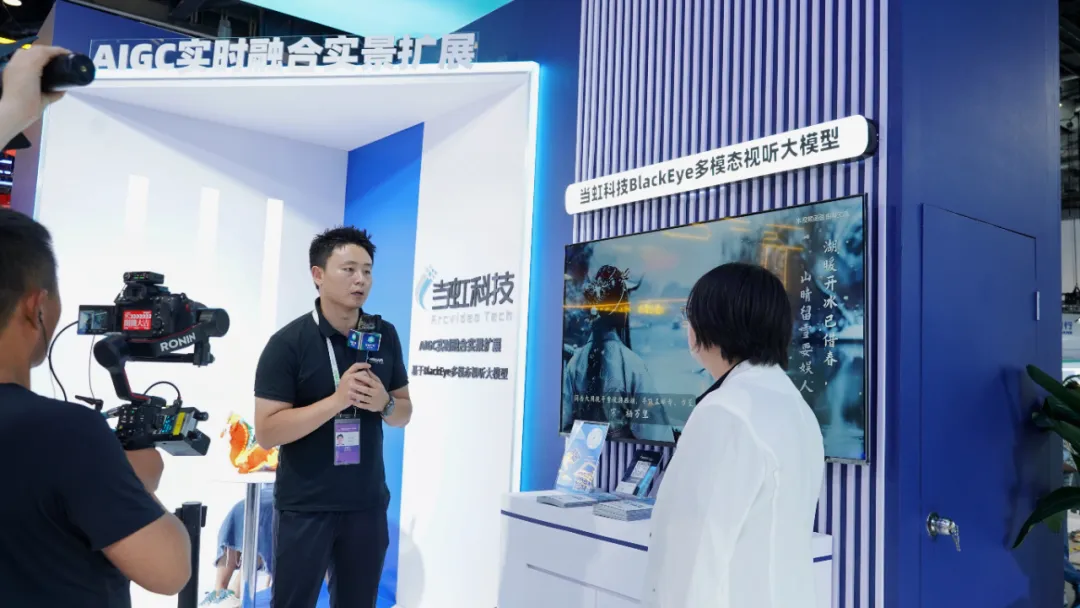

(工作人员为媒体介绍BlackEye多模态视听大模型)

现场这段《江南·忆》视频短片,便是由生成式算法完成的。

现场工作人员介绍,在基于BlackEye的创作平台上,当虹科技还实现了“视频文案——分镜脚本——编辑工具”的全流程AI赋能。

目前,可以生成品牌宣传、广告营销、文旅推广、情感关系等多种文案类型。待文案确定后,可以一键生成分镜脚本,包括场景、景别、角度、拍摄方式,等等。最终,导入剪辑工具,进一步进行包装制作。

这引起现场不少新媒体从业人员申请试用。他们认为,相比传统视频生成方式,不仅可以大幅节约创作成本,还能在文案、脚本阶段激发创造力,给我们带来更多创作灵感。

本文作者可以追加内容哦 !