7月18日,OpenAI宣布推出GPT-4o mini,一个极具成本效益的小型模型。

小而优

OpenAI把GPT-4o mini描述为,一个具有卓越文本智能和多模态推理能力的小模型。

据OpenAI介绍,GPT-4o mini在MMLU上的得分为82%,目前在LMSYS排行榜上的聊天偏好方面优于GPT-4。

GPT-4o mini在文本智能和多模态推理方面的学术基准测试中超越了GPT-3.5 Turbo和其他小型模型,并且支持的语言范围与GPT-4o相同。

GPT-4o mini在函数调用方面也表现出色,可以使开发人员构建获取数据或使用外部系统采取行动的应用程序。此外,与GPT-3.5 Turbo相比,GPT-4o mini的长上下文性能有所提高。

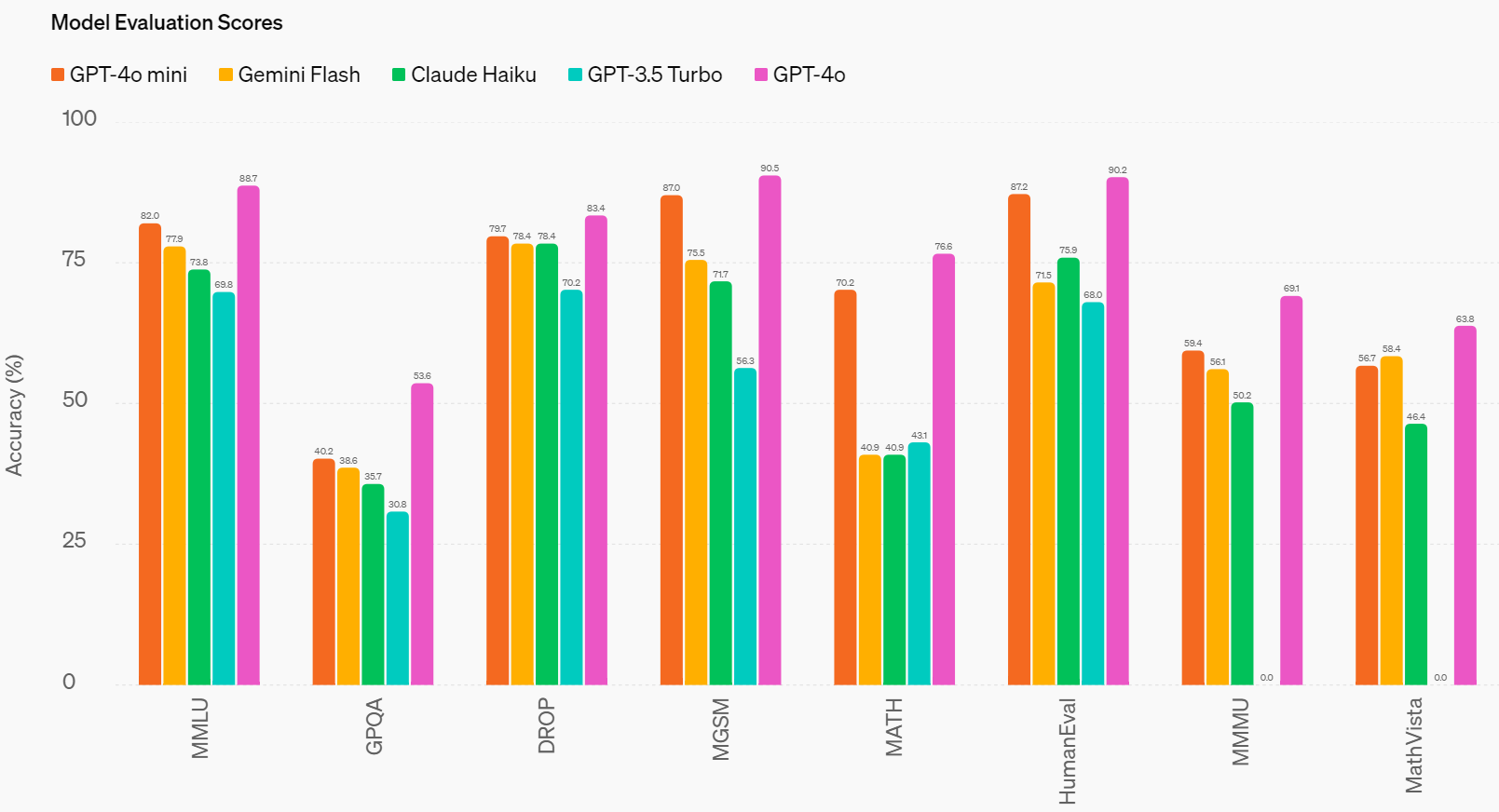

GPT-4o mini已经在几个关键基准上进行了评估。

推理任务:GPT-4o mini在涉及文本和视觉的推理任务上优于其他小型模型,在文本智能和推理基准MMLU上的得分为82.0%,而Gemini Flash为77.9%,Claude Haiku为73.8%。

数学和编码能力:GPT-4o mini在数学推理和编码任务中的表现优于市场上之前的小型模型。在测量数学推理的MGSM上,GPT-4o mini得分为 87.0%,而Gemini Flash得分为75.5%,Claude Haiku得分为71.7%。在测量编码性能的HumanEval上,GPT-4o mini得分为87.2%,而Gemini Flash得分为71.5%,Claude Haiku得分为75.9%。

多模态推理:GPT-4o mini在多模态推理评估MMMU中也表现出色,得分为59.4%,而Gemini Flash为56.1%,Claude Haiku为50.2%。

OpenAI还提到,公司在与Ramp等公司合作时发现,在执行从收据文件中提取结构化数据或在提供线程历史记录时生成高质量电子邮件响应等任务时,GPT-4o mini的表现明显优于GPT-3.5 Turbo。

更低的成本

尽管性能十分优秀,但这不是GPT-4o mini最引人注目的地方,其最大的亮点是价格实现了大幅下降。

OpenAI表示,开发人员使用GPT-4o mini时,每100万个输入tokens需支付15美分,每100万个输出tokens需支付60美分,这一定价比之前的Frontier型号便宜一个数量级,比GPT-3.5 Turbo便宜60%以上。

该公司表示,成本的降低将有助于开发受活动量影响的应用程序。

GPT-4o mini将凭借低成本和低延迟来实现多项任务,例如链接或并行化多个模型调用(如调用多个API)、将大量上下文传递给模型(如完整的代码库或对话历史记录),或通过快速、实时的文本响应与客户互动(如客户支持聊天机器人)。

目前,GPT-4o mini的应用程序接口支持文本和视觉,未来还将支持文本、图像、视频和音频输入和输出。该模型的上下文窗口可容纳128K个输入token,每个请求最多支持16K输出token,并且拥有截至2023年10月的知识。由于改进了与GPT-4o共享的tokenizer,现在处理非英语文本更具成本效益。

在安全性方面,GPT-4o mini内置了与GPT-4o相同的安全缓解措施。据了解,有超过70位来自社会心理学和错误信息等领域的外部专家对GPT-4o进行了测试,以识别潜在风险,OpenAI已经解决了这些风险。OpenAI称,团队还将致力于利用研究得出的新技术来提高GPT-4o mini的安全性。

OpenAI表示,GPT-4o mini现在已向免费用户和付费ChatGPT Plus和Team用户推出,并将于下周向企业客户提供。GPT-4o mini将取代ChatGPT中的旧型号GPT-3.5 Turbo。

本文作者可以追加内容哦 !