盖世汽车讯 可与物理世界互动的具身AI(人工智能)代理在各种应用中都具有巨大潜力,但缺乏训练数据仍是其面临的主要障碍之一。据外媒报道,为解决该挑战,英国伦敦帝国理工学院(Imperial College London)和谷歌DeepMind的研究人员推出了一种名为扩散增强型代理(Diffusion Augmented Agent,DAAG)的新型框架,利用了大型语言模型(LLM)、视觉语言模型(VLM)以及扩散模型的力量,以提升具身代理的学习效率和迁移学习能力。

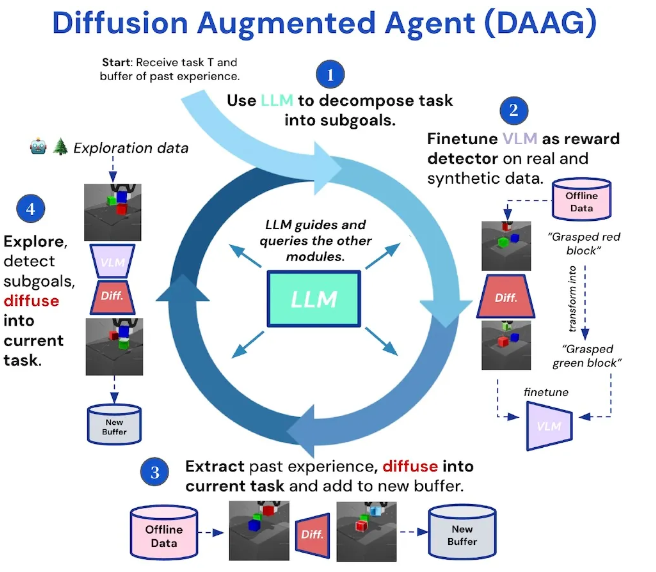

DAAG模型(图片来源:arXiv)

为何数据效率对具身代理很重要?

近年来,LLM和VLM取得了令人惊叹的进展,为其应用于机器人和嵌入式AI领域带来了希望。但是,虽然LLM和VLM可以在从互联网上抓取来的大量文本及图像数据集上进行训练,但是具身AI系统需要通过与物理世界的交互来学习。

现实世界对具身AI系统的数据收集提出了几个挑战。首先,物理环境比数字世界更加复杂和不可预测。其次,机器人和其他具身AI系统依赖于物理传感器和执行器,而此类传感器和执行器可能会有速度慢、有噪声、易故障等问题。研究人员们认为,克服这一障碍的关键在于更有效地利用该代理现有的数据和经验。

DAAG是什么?

伦敦帝国理工学院和DeepMind团队提出的扩散增强型代理(DAAG)框架旨在通过利用过去的经验、生成合成数据,以让代理更高效地学习任务。研究人员将DAAG设计成一个终身学习系统,在该系统中,代理可以不断学习,并适应新的任务。

DAAG在马尔可夫决策过程(Markov Decision Process,MDP)的背景下运行,在每个回合开始时,该代理会接收到任务的指示,观察环境的状态,采取行动,以试图达到与所描述任务相一致的状态。其有两个记忆缓冲区:一个特定任务相关缓冲区(存储当前任务的经验);一个“离线终身缓冲区”(存储所有过去的经验,无论是为哪个任务收集的,也不管其结果如何)。

DAAG结合了LLM,VLM和扩散模型的优势,以打造能够对任务进行推理、分析环境并重新利用过去的经验以更高效学习新目标的代理。LLM充当该代理的中央控制器。当该代理接收到一个新任务时,LLM会解释指令、将指令分解成更小的子目标,并与VLM和扩散模型协同,以获得达成目标的参考框架。

为了充分利用过去的经验,DAAG还采用名为事后经验增强(Hindsight Experience Augmentation,HEA)的机制,该机制使用VLM和扩散模型增强该代理的记忆力。

首先,VLM会对经验缓冲区中的视觉观察结果进行处理,并将此类结果与期望达成的子目标进行比较,将相关的观察结果加入到该代理的新缓冲区中,以帮助指导其行动。

如果该经验缓冲区内没有相关的观察结果,扩散模型就会发挥作用,会生成合成数据,帮助该代理“想象”其期望的状态会是什么样子,从而让该代理能够在不与环境进行物理互动的情况下,探索不同的可能性。

研究人员将DAAG与HEA描述为首个“提出完全自动化管道、无需人类监管、利用几何与时间一致性以生成一致的增强型观察结果”的方法。

DAAG的好处是什么?

研究人员在多个基准测试和三个不同的仿真环境中对DAAG进行了评估,并测量了其在导航和物体操作等任务上的性能。他们发现,与基准强化学习系统相比,该框架得到了显著的改进。

例如,DAAG驱动的代理即使在没有提供明确奖励的情况下,也能成功学习以达成目标。与没有使用该框架的代理相比,此类代理能够更快地达成目标,并且与环境的交互更少。此外,DAAG更适合高效地重新采用之前任务的数据,以加速针对新目标的学习过程。

在任务之间迁移知识对于研发能够不断学习并适应新情况的代理而言至关重要。DAAG在让具身代理高效迁移学习方面取得成功,有望为实现更强大、适应性更强的机器人以及其他具身AI系统铺平道路。

研究人员在论文中写道:“该项研究为解决机器人学习的数据短缺问题以及研发更具能力的代理提供了有发展前景的方向。”

本文作者可以追加内容哦 !