自身努力融入时代洪流。

作者 | 木鱼 编辑 | 小白

作者 | 木鱼 编辑 | 小白

在所有存储芯片中,HBM(High Bandwidth Memory,高带宽存储器)突破了内存瓶颈,成为当前AI GPU存储单元的理想方案和关键部件,更有人将其看作是“最适用于AI训练、推理的存储芯片”。 作为唯一满足AI高性能计算要求的量产存储方案,市场机构认为其未来的需求量将会呈现爆发式增长。

根据TrendForce预测,2023年全球搭载HBM总容量将达2.9亿GB,同比增长近60%;11月份以来,产业链上的各大厂商接连放出利好消息,也可以侧面窥测HBM的受欢迎程度:SK海力士预测,HBM市场到2027年将出现82%的复合年增长率。

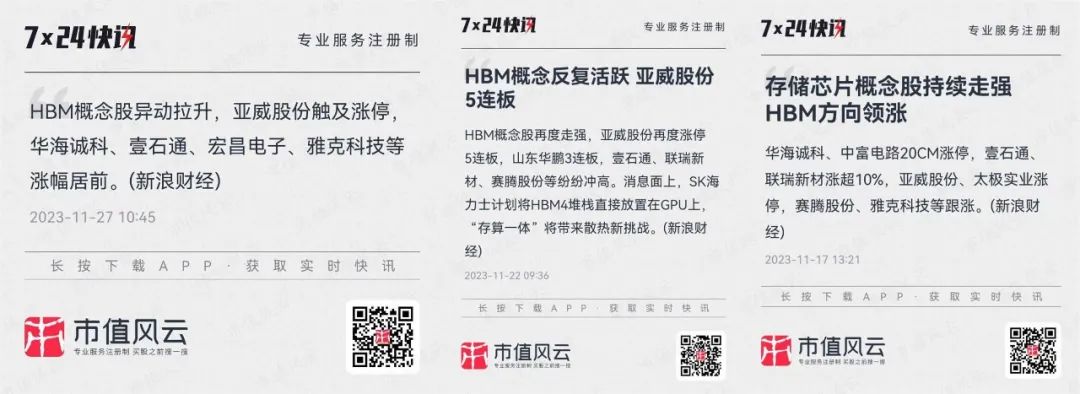

英伟达推出新一代的GPU H200,为全球首款搭载HBM3e内存的GPU;这位AI时代的新宠,也理所当然的成为资本市场的新宠,相关概念股早已经蠢蠢欲动。两家存储器芯片巨头三星和SK海力士准备将HBM产量提高至2.5倍;SK海力士计划将HBM4堆栈直接放置在GPU上;

半导体设备供应商Lam Research(泛林集团)正在向三星和SK海力士独家供应TSV蚀刻设备和镶嵌设备,均用于HBM生产等等。

(来源:) 其中,HBM封装所用的环氧塑封料,最主要的功能填充材料是Low-球形二氧化硅或Low-球形氧化铝。

(来源:) 其中,HBM封装所用的环氧塑封料,最主要的功能填充材料是Low-球形二氧化硅或Low-球形氧化铝。

追加内容

本文作者可以追加内容哦 !