依照当前主流Transformer技术路径,算力需求成本变得极度昂贵,OpenAI的GPT4耳目一新的效果,让$英伟达(NASDAQ|NVDA)$AI芯片量价齐升,然而客户们从优化算法层面开始反水了。

(1)AI公司确实没钱了

Stability AI CEO 及核心团队相继离职,公司被曝每月运营成本高达800万美元以上,完全入不敷出。不是中国 AI 圈穷,而是全球 AI 圈都真的没钱了——大模型就像个“碎钞机”,无论硅谷公司,还是中国公司,都难以承受。

海外机构测算,爆火的文生视频模型Sora,如果全量放开训练好,芯片成本就需要至少800亿美元的投入……真不便宜。

(2)算法端降本,MoE 架构发光

日前,发布的JetMoE能够以在10万美元的训练成本达到媲美LLaMA2级别的性能。

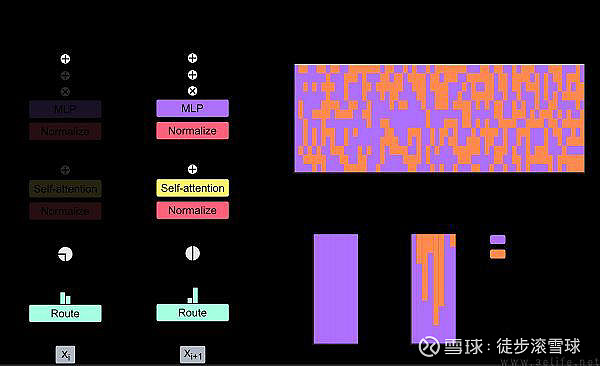

MoE,全称Mixture of Experts,是一种神经网络模型。这个模型最大的优势就是可扩展性强,它允许我们在保持性能的同时,降低推理成本。将神经网络拆分为多个子网络,让它们共同处理一个输入,然后通过权重综合得出结果。这样的结构,既可以提高模型的训练和推理速度,又可以降低训练不稳定的风险。

MoE架构也充满挑战:扩展性强,推理成本低,训练速度快,性能优秀,但需要解决“专家”网络训练不均衡的问题。

最主要的问题就是如何保证每个“专家”都能得到充分训练。为了解决这个问题,引入了一个门控网络(Gate Network),通过它来调控哪些“专家”参与回答以及他们的权重。但是,如果门控网络倾向于选择某些特定的“专家”,可能会导致其他“专家”得不到充分的训练,从而造成训练不稳定。

今年 1 月,Minimax 宣布发布国内首个 MoE 大语言模型 abab6;在接下来的几个月,Google、APUS、达观、阶跃星辰等企业以及马斯克,都纷纷发布了自己的 MoE 模型。

以MiniMax为例,其客户包括金山办公、小红书、腾讯、小米、阅文集团等知名公司。阿里巴巴作为头部资本,已承诺参与MiniMax下一轮融资的领投,规模达到6亿。

(3)不玩 MoE,就搞小模型

AI PC概念火热,厂商需要低降本反应速度高的模型。

尽管现在 AI PC、AI 手机是噱头成分居多,真正在 C 端有决定意义的价值点较少。

但这趟列车已经绑定了太多的人:高通、英特尔、三星、联想……以及一系列基础模型厂商、模型中间件厂商。

(4)谷歌新MoD架构,节省更多计算资源

日前有消息显示,谷歌发布的Mixture-of-Depths(MoD)改变了以往Transformer架构的计算模式。

通过动态分配大模型中的FLOPs(运算次数或计算资源),优化不同层次模型深度中的分配,限制给定层的自注意力和MLP计算的token数量,MoD可跳过一些不必要计算,迫使神经网络学会主要关注真正重要的信息,实现只给需要准确预测的token分配更多计算资源,从而显著提高训练效率和推理速度。

例如,虽然预测下一个句子的内容很难,但预测句子结束的标点符号很简单,如果给两者分配同样的计算资源,那么后者明显会浪费资源、而MoD则可避免这种情况。

据谷歌方面发布的相关测试结果显示,在等效计算量和训练时间上,MoD每次向前传播所需的计算量更小,而且后训练采样过程中步进速度提高50%。

据了解,谷歌研究团队还探讨了MoD和MoE结合的可能性MoDE,而且结果表明而这一结合能提供更好的性能和更快的推理速度。

(5)GPT5若一骑绝尘,下游部分客户可能退出

当前的百花争艳难以为继,对英伟达来讲算得上好事,至少大公司们、风险资本愿意掏钱,商业股市还能讲。

GPT5表现太好的话,总体需求减少、客户话语权增强,对干硬件的公司就不是好事了。

英伟达是一家优秀的公司,只不过所有优秀的公司在行业大趋势面前,在商业定律面前都逃不开漩涡

$高新发展(SZ000628)$ $鸿博股份(SZ002229)$

#华为算力供不应求,如何挖掘相关机会?#

本文作者可以追加内容哦 !