仟江水商业电讯(4月29日 北京 委托发布)4月29日,在“创芯·生生不息——进迭时空2024年度产品发布会”上,进迭时空CEO、创始人,陈志坚博士宣布将开源进迭时空在自研RISC-V AI CPU上的核心技术,包括AI扩展指令和全部AI软件栈代码,助力RISC-V生态建设。为了RISC-V开发者们便捷使用这些AI代码,进迭时空正在做代码整理,预计最晚将在今年Q4季度开源所有AI软件栈代码。

(视频:进迭时空开源16条AI指令)

“我们将开源我们在AI上的全部核心技术,包括我们扩展的16条AI指令和全部的AI软件栈源代码。”——陈志坚,进迭时空CEO、创始人

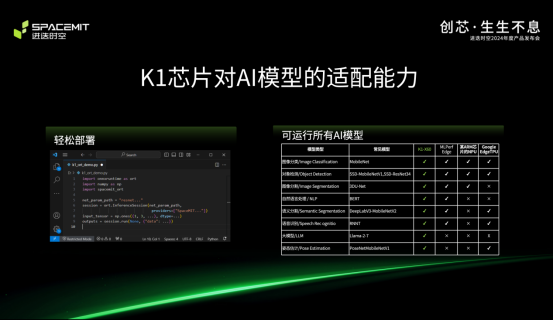

陈志坚博士在发布会上发布的全球首颗 8核 RISC-V AI CPU——SpacemiT Key Stone™ K1(以下简称“K1芯片”),正是基于这次即将开源的AI代码,创新性地以CPU核的方式提供通用AI算力,使得所有AI模型可以快速在K1芯片上部署,解决了当下ARM类芯片普遍存在的部署难的问题,整体性能全面领先于ARM同等微架构芯片产品。

据陈志坚介绍,面向AI应用中算力占比最高的卷积和矩阵乘法,K1芯片遵循RISCV基金会IME Task Group的规则,复用Vector寄存器实现了16条AI指令,其中4条矩阵乘指令可以加速包括矩阵乘和卷积计算,12条滑窗矩阵乘指令采用了首创的寄存器内数据拼接技术,可以将卷积计算时的计算访存比提高50%,在提高端侧AI模型性能的同时降低了AI计算功耗。通过这16条高效的AI指令,在运行同样AI模型时,K1动态执行指令数仅为ARM的20%左右,AI性能得到极大提升。

目前,世界主流AI推理生态主要包括英伟达的GPU推理生态和X86的CPU推理生态。K1芯片通过复用X86成熟的AI推理软件栈,把底层核心算子改用RISC-V Vector和AI指令,其余部分复用CPU推理软件栈,从而快速接入国际主流的AI推理生态。据了解,使用K1芯片,通过Python调用和执行一个开源模型,只要不到10行代码,就可以快速部署一个AI模型。目前K1芯片已累计验证了包括图像分类、图像分割、目标检测、语音识别、自然语言理解等多个场景的约150个模型的优化部署,timm、onnx modelzoo、ppl modelzoo等开源模型仓库的支持通过率接近100%,从理论上证明K1芯片能够支持所有的公开onnx模型。

(视频:SpacemiT Muse™ Book 大模型及AI性能展示视频)

“要把温暖传递下去”——谈到此次开源,陈志坚表示,进迭时空坚信RISC-V可以做出有代差级竞争优势的RISC-V芯片和生态产品。“一路走下来,才发现芯片创业,尤其是RISC-V芯片创业远比预想的还要难得多很多”。进迭时空凭借着对RISC-V的信仰、对开源文化的热爱跑完SpacemiT Key Stone™ K1芯片“研发-流片-量产-应用”全生命周期,仅用了不到900天。在这个过程中,他无数次被开发者们的热情与温暖打动。发布会的主题为“创芯·生生不息”,也代表着进迭时空在面向Robot Computer时代开发高性能芯片的同时,也将在RISC-V生态建设方面长期、持续投入。

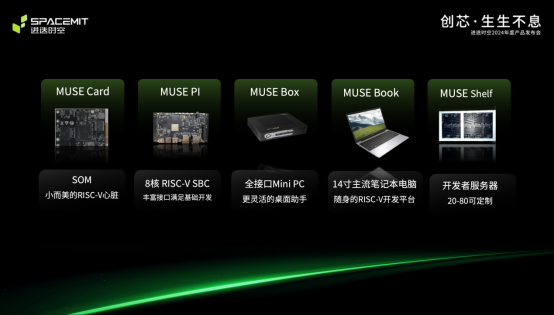

据悉,进迭时空在这场年度发布会上还发布了搭载中K1芯片的SpacemiT Muse™ Book、SpacemiT Muse™ Pi和SpacemiT Muse™ Box等5款生态产品,近期将通过官网启动预售,进一步为全球RISC-V开发者提供最好便捷,最好用的软硬生态产品。(文/段佳惠)

(视频:SpacemiT Muse™ 生态产品展示视频)

本文作者可以追加内容哦 !