—

我们期待大模型能够通过分析和处理这些大量的数据,实现信息的最高程度的压缩,自动发现世界运转的基本规律,让模型表现出与人类智能相匹配的能力。

来源 / 信息化与数字化 (ID: HERO_HAS_A_CODE)

作者 / 沈旸

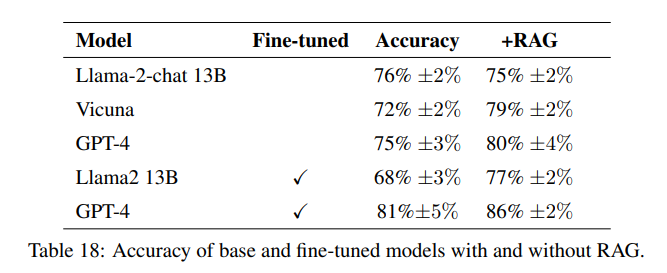

今年1月份,微软的几位学者发布了一篇论文《“RAG与微调:流水线、权衡与农业案例研究”》。这篇微软的论文探讨了在将特定领域的数据整合到大型语言模型(LLM)中的两种方法的效果——检索增强生成(RAG)和微调。研究特别聚焦于农业行业,这个领域的人工智能应用仍然相对较少。研究人员提出了一个包括从PDF提取数据、生成问答对、并评估模型表现的流水线,使用的模型包括Llama2-13B、GPT-3.5和GPT-4。

RAG和微调这两种方法都能够有效提升模型性能。通过微调模型,准确率提升了6个百分点以上,而RAG方法又额外提升了5个百分点,大概可以做到86%附近,但是都离100%还是有一段的距离。

论文地址: https://arxiv.org/pdf/2401.08406

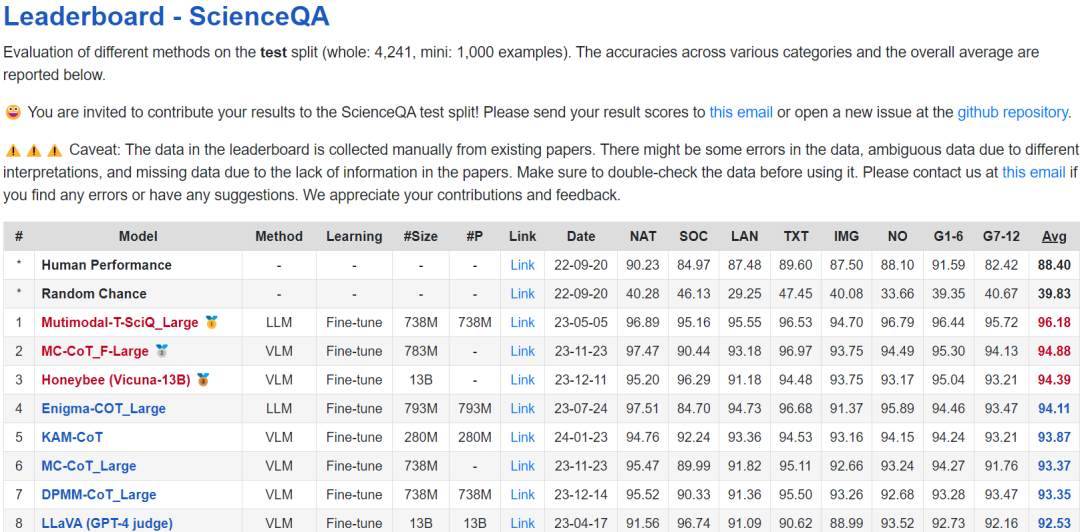

当我们看其他关于大模型准确率的榜单,例如ScienceQA的准确率中,最优秀的大模型的准确率大概是96%左右。目前在大规模的准确率评测中,还没出现能够达到100%准确率的大模型。

https://scienceqa.github.io/leaderboard.html

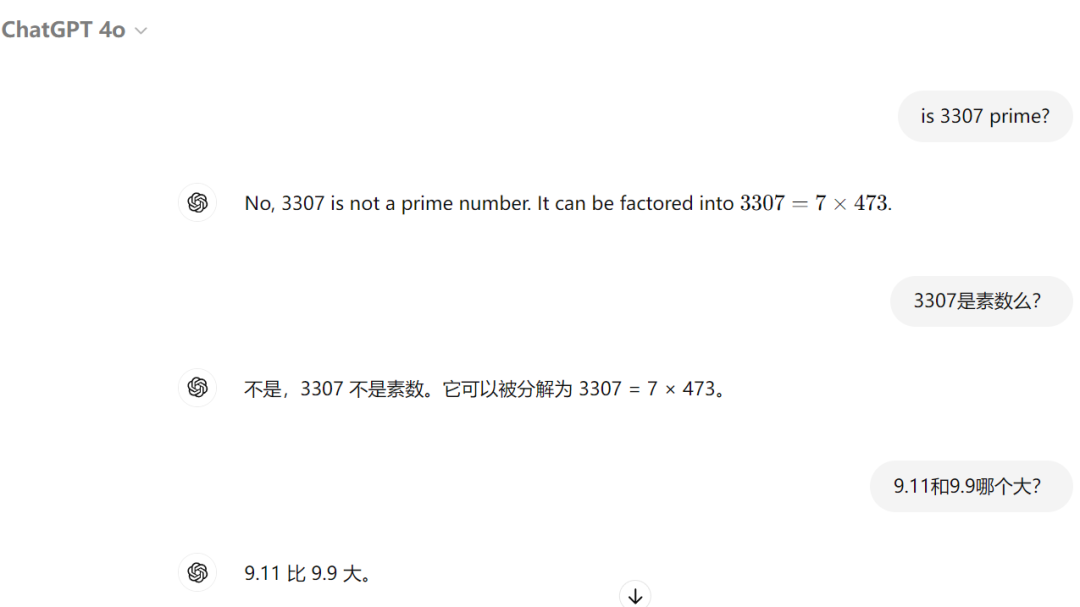

在最近比较火的一个大模型翻车测试中,9.11和9.9哪个更大的问题中,几乎所有的大模型都翻车了,最强的GPT4也不例外。对于数学题来说,大模型可能是最不擅长的,用普通的计算器消耗最小的能量就可以得到正确答案,但是通过大模型几百亿的参数计算后反而是得到了一个错误的答案。

大模型的准确率影响了其在很多场景中的落地,例如金融领域,例如医疗领域,这些领域对准确率要求几乎是100%,因为失误的代价太大。在这些领域中还是用常规的AI工具。随着大模型技术的发展,准确率也在不断提升,但是其最终能够达到100%么?

大模型的本质是有损压缩后的概率模型

在回答上一段内容提出的问题之前,让我们读一下下面这篇文章,能帮助我们理解语言大模型的本质:

《 大模型:泛化即智能,压缩即一切?》 2024年2月28日,OpenAI 的核心研发人员 Jack Rae 在参加 Stanford MLSys Seminar 的访谈时进行了一个名为 Compression for AGI 的主题分享,其核心观点为:AGI的一个关键目标是通过最小描述长度(Minimum Description Length, MDL)的原则来压缩信息。这意味着模型应该能够以最简洁的形式表达观察到的现象,从而实现对世界的深刻理解和泛化能力。尽管这种压缩方法展示了极大的潜力,Rae也指出目前的生成模型在处理复杂任务时仍然存在一定的局限性,例如在理解和处理多模态数据时的能力有限。

Ilya Sutskever, OpenAI的联合创始人兼首席科学家,在多次讨论中强调了压缩与无监督学习之间的紧密关系。他提到,一个优秀的压缩器能够识别和利用数据集中共享的模式,这与无监督学习在无标签数据中发现结构的过程非常相似。他将无监督学习视为对最优数据压缩的近似,这意味着大规模神经网络(通过梯度下降训练)实际上是在模拟这种最优的压缩器。通过这种方式,压缩不仅仅是一种技术手段,而是推动人工智能能力极限的重要原则。

举一反三,用简单的道理来描述复杂的世界,往往是智慧的象征。在程序员的世界里,大家都喜欢用最简短的代码来实现同样的功能,压缩率越高的代码往往意味着程序员的能力越强。同样的,我们可以类比一些经典的例子来理解压缩在科学领域的重要性。比如,在计算1加到10000的总和时,我们可以采用逐一相加的方法,但这显然效率低下。而通过高斯求和公式,我们可以直接得出结果:( 1 + 10000 ) × 10000 / 2 ,这种方法通过公式化的压缩,极大地提高了计算的效率,也代表了人类高级智慧的结晶。

现代大语言模型也是在试图将大量的语言数据压缩成一个可以高效生成和理解语言的模型。这种高效压缩不仅在提升模型性能方面起着至关重要的作用,也为我们理解和进一步发展这些模型提供了新的视角。

在特德·姜的著名文章《 特德·姜:ChatGPT 是网络上的一个模糊的JPEG 文件》中,他将ChatGPT比喻为有损压缩后的自然语言交互接口。这种比喻揭示了大语言模型的局限性:尽管这些模型可以高效地生成语言,但由于压缩的本质,它们在处理复杂细节和精确信息时可能会丢失一些关键信息。特德·姜的观点与Sutskever和Rae的理论形成了有趣的对比,表明大语言模型在信息压缩过程中可能会不可避免地丧失一些原始数据的细节,从而导致某些情况下的误差。

有损压缩(信息的模糊和还原):

这一类压缩常见于图像和视频领域,例如将高分辨率图像压缩为体积更小的低分辨率图像。类似地,大语言模型在生成文本时可能也在进行某种形式的有损压缩,以提高生成速度和效率,但代价是潜在信息的丢失。

一个有趣的实验是利用大模型的“图片生成文字”功能对图像视频进行极大压缩,然后再通过“文字生成图片”的功能来还原原始图片。如果你经常进行这样的实验,就会发现通过这种方式还原的图片与原始图片始终存在差异。这表明,尽管大模型能够捕捉并再现信息的主要特征,但在压缩和还原的过程中,一些细节不可避免地会丢失。这也是为什么通过大模型对话来微调生成图片时,往往难以精确控制图像生成的走向。

类似地,双胞胎的DNA虽然完全相同,使得他们在出生时有着极其相似的外貌。通过基因检测,可以确定个体独特的DNA信息,得到一个超度压缩的特征;但是,如果通过对DNA信息来对个体的外貌和体型进行预测,却无法做到完全精准。随着时间的推移,双胞胎在成长过程中会经历不同的环境、生活方式和经历,最终导致他们在外貌、性格和行为上产生显著差异。

这与大语言模型中发生的有损压缩类似,模型在学习和生成语言时,通过概率分布的计算实现了信息的压缩,虽然在还原信息的时候会丢失一些细节或精确度,但仍然能够生成总体上合理和连贯的输出。

无损压缩(从现象总结为规律,再到推演预测):

无损压缩的经典例子是将文本文件压缩为ZIP文件,压缩后的数据可以完全恢复原状。学者们发现,通过大语言模型进化的压缩算法可以实现更高效的压缩效果,这表明这些模型在本质上是一种高级的无损压缩器,能够捕捉和保留数据中的重要结构和模式。

同样的,通过对事务的初始状态、数学公式、物理规律和逻辑推导,来预测事务的变化,也属于无损压缩的范畴。牛顿在发现万有引力定律时,将复杂的天体运动现象压缩为一个简单的公式,认为这个定律可以解释和预测宇宙中的一切现象。他坚信,通过他的数学公式和物理定律,所有自然现象都可以被精确地计算和预测。

爱因斯坦的工作可以看作是科学史上最卓越的“压缩”案例之一。除了他著名的相对论之外,他在晚年致力于统一场论的研究,试图将电磁相互作用、强相互作用、弱相互作用和引力这四种基本相互作用整合到一个统一的理论框架中。这一尝试代表了对自然规律更高级的抽象和压缩。爱因斯坦希望通过找到一个能够描述所有基本相互作用的公式,实现对物理世界更深层次的理解和简化。

大模型为什么做不到极限的无损压缩呢?

下图展示了常见大模型的参数量与其训练数据量之间的关系。从中可以看出,不同模型的压缩率存在显著差异,尤其是一些参数量较小的模型,往往表现出更高的压缩率。这意味着,较小的模型通常使用更模糊和抽象的概率分布来模拟原始信息。

由于这些模型在参数量有限的情况下进行信息压缩,它们在试图还原训练数据中的细节时,准确性往往会降低。这种高压缩率虽然有助于提高模型的效率,但也不可避免地导致信息的丢失,使得模型在处理复杂或细节丰富的任务时,表现出一定的局限性。这表明,虽然有损压缩可以提高模型的处理速度和存储效率,但在保持信息完整性方面仍存在挑战,也就不可能达到100%的准确率。

我们常常会发现,大模型在处理事实性问题时容易出错,例如关于某年某月的新闻事件,或者某个名人的出生年月日及其人物关系。这是因为这些事实性内容往往是高度具体的事实性内容,很难通过压缩算法进行有效的处理。例如,每一个人物的姓名与身份证号码的匹配关系,具有高度的信息量和唯一性,这样的内容几乎不可能被压缩,只能通过逐一记忆来实现。

但是我们目前给大模型训练的数据往往是这些具体而又很难被压缩的信息!这些看起来信息量很高的数据对于逻辑推理和寻找规律来说,数据,因为其无法被进一步抽象。

单纯的记忆并不是大语言模型的强项,对于这些事实性内容,AI大模型实际上并不比传统的搜索引擎或数据库更为有效。传统的搜索引擎和数据库擅长存储和快速检索这些精确的信息,而大语言模型则更侧重于语言生成和模式识别。因此,在处理涉及精确数据的任务时,大模型可能会因为信息压缩和泛化的需求而导致细节的丢失或错误。相比之下,搜索引擎和数据库能够更可靠地提供精确的事实信息,尤其是在涉及大量细节的情况下。

大模型无法正确回答“9.11和9.9哪个更大”的问题,可能是因为在其训练过程中,缺乏大量的数学题目进行训练。即便有部分的数学计算,我们也无法涵盖所有可能的数学问题。此外,模型的概率分布可能受到大量非数学信息的干扰。例如,如果9.11和9.9在训练数据中常常作为版本号出现,那么模型可能会认为9.11比9.9大,因为在版本号的语境中,这种逻辑是成立的。这种混淆表明,目前的大模型可能还并没有找到数理化等科学领域的终极信息压缩规律。

我们很多人对大模型的期待是,把数学课本输入给大模型,大模型就能够掌握数学规律并解答数学题,甚至能给我们实现一个万能计算器的功能。当我们提供给模型大量的天文观测视频和数据时,它能自主地总结出类似于万有引力这样的物理定律。我们期待大模型能够通过分析和处理这些大量的数据,实现信息的最高程度的压缩,自动发现世界运转的基本规律,让模型表现出与人类智能相匹配的能力。但是仅仅靠Transformer架构的语言大模型,仅仅靠语言信息的压缩,真的能实现这样的目标么?

语言≠思维 《语言≠思维,大模型学不了推理:一篇Nature让AI社区炸锅了》

近日,一篇麻省理工学院(MIT)等机构发表在顶级学术期刊《自然》杂志的文章观察到,人类大脑生成和解析语言的神经网络并不负责形式化推理,而且提出推理并不需要语言作为媒介。

论文链接: https://www.nature.com/articles/s41586-024-07522-w

没有语言,是否有可能发展出数理化这样具有强大逻辑推理能力的学科?语文或外语成绩不佳,是否一定会影响到数理化的学习呢?许多偏科的学生可能会认同这一观点:语言大模型可能并不直接负责推理,人类大脑中的其他功能区可能更擅长进行复杂的逻辑推理和分析。

语言确实是我们沟通和表达的工具,但深度的逻辑推理往往发生在我们独处和沉默的思维过程中。在这些时刻,语言的表达能力和带宽往往无法跟上思维的速度。例如,17世纪数学家费马在他的笔记中提出了著名的“费马大定理”,但他却在边注中写道:“可惜这里的空白处太小,写不下我的证明。”这句话不仅说明了语言在表达复杂思维时的局限性,也表明人类的深层次推理能力可能远超出语言所能描述的范围。

“文无第一,理无第二”这一现象广泛存在。在数理化等学科中,顶尖的学生往往能够在考试中获得稳定的满分,而在语文科目中,几乎没有学生能够始终保持满分。这是因为数理化题目通常有唯一正确的答案,解题过程也可以通过逻辑推导和验证来确保准确性。数理化学科的优美之处在于其高度的逻辑性和可验证性。

数学题目通常可以在解答后立即知道对错,科学实验也能够通过反复验证来确认理论的正确性。然而,语文的评判标准相对主观,涉及到理解、表达和思维的多样性,因此在评分时难以做到绝对一致和完全公正。

这种特点也解释了为什么目前的大语言模型难以实现100%的准确率:模型在生成推理和语言内容时,缺乏真实世界中的“仿真”和“校验”机制。虽然大模型可以输出看似逻辑严密的算法或代码,但目前它们无法确保这些结果绝对正确,也无法调用一个真实的运行环境来帮你校验这些代码是否能运行正常,以及怎样校验代码运行后的结果是否正确。

相比之下,人类的大脑拥有“脑海仿真”的能力,能够在做出决策前,模拟可能的后果,并进行逻辑推理,并产生非常真实的“画面感”的结果预测。这种仿真不仅帮助人类严肃评估每一个决策的利弊,还能够通过外界的工具、实践和观察,验证推理的正确性。这种能力使得人类在面对复杂决策时,能够做出更加理性和精确的判断。

我们当前的语言大模型仍然缺少对过程的全面模拟和对结果的准确验证,这些将需要大模型与各种API/RPA与真实的世界进行互动和校验。随着AI技术的发展,如何探索新的架构体系,赋予AI大模型更强的逻辑推理能力和自我校验机制,仍是未来研究的重要方向。

思考与后记

如果当前的语言大模型在理论上就没法达到100%的精准度,那么还有必要不断地加大投入去追求100%的指标么?

我们是否应该充分发挥大模型的语言压缩的特点,在一些不太追求精准度的场景下去落地实践呢?例如,企业里的组织和沟通,往往是有大量的语言文字信息。

对于各种信息的上传下达,是否可以充分利用大模型的特点呢?我们下篇内容一起来探讨。

专题推荐

点击图片即可跳转阅读

点个「在看」,和我们一起聊聊

本文作者可以追加内容哦 !