盖世汽车讯 据外媒报道,谷歌DeepMind宣布推出两款用于控制机器人的新型人工智能模型:Gemini Robotics和Gemini Robotics-ER。该公司声称,这些模型将帮助各种形状和大小的机器人更有效、更细致地理解世界,并与物理世界互动,为人形机器人助手等应用铺平道路。

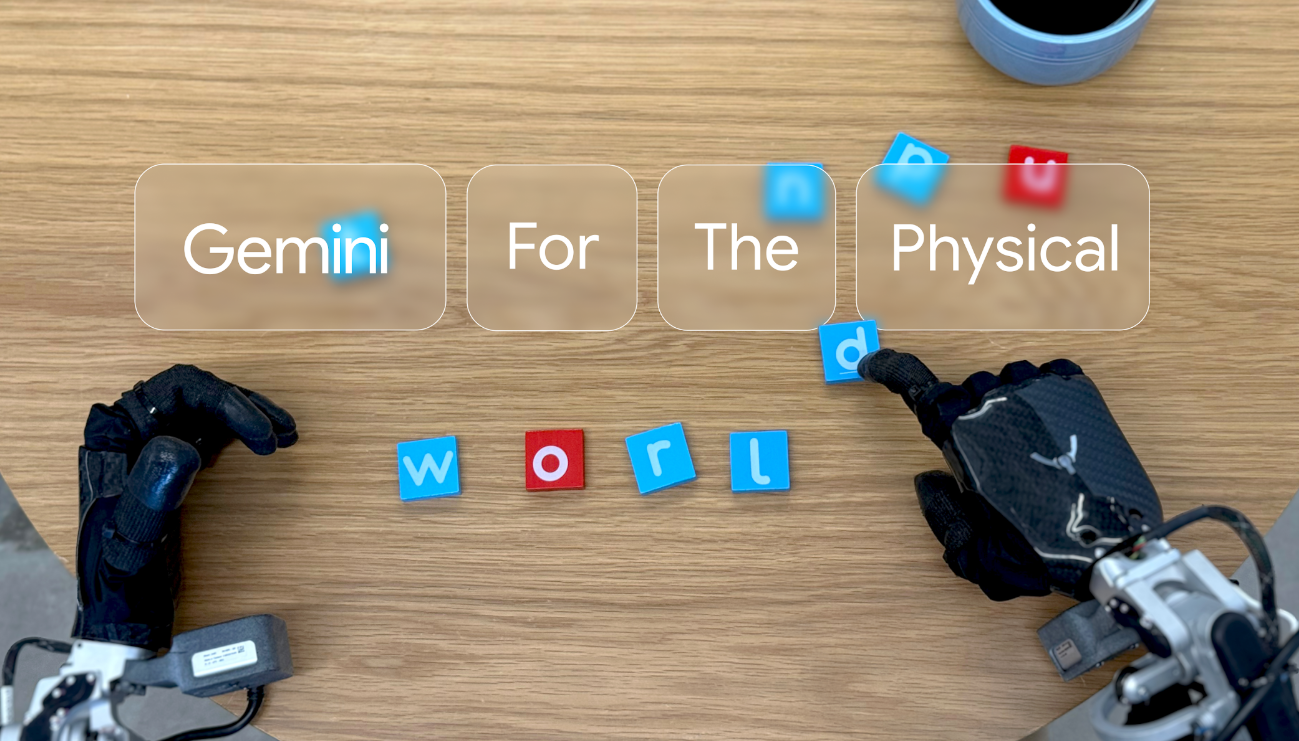

图片来源:DeepMind

值得注意的是,尽管机器人平台的硬件在稳步发展,但创建一个能够安全、精确地自主驾驶这些机器人穿越新场景的人工智能模型却难以实现。

为此,谷歌的新模型基于其Gemini 2.0大型语言模型建立,增加了专门用于机器人应用的功能。Gemini Robotics包括谷歌所谓的“视觉-语言-动作”(VLA)能力,使其能够处理视觉信息、理解语言命令并产生身体动作。相比之下,Gemini Robotics-ER专注于“具身推理(embodied reasoning)”,增强了空间理解能力,让机器人专家将其连接到现有的机器人控制系统。

例如,使用Gemini Robotics,用户可以要求机器人“拿起香蕉并放入篮子”,它将使用场景的摄像头视图识别香蕉,引导机械臂成功执行动作。或者可以说“折一只折纸狐狸”,它将利用其对折纸的了解以及如何仔细折叠纸张来执行任务。

2023年,谷歌推出RT-2,它代表着朝着更通用的机器人功能迈出了显著的一步,利用互联网数据帮助机器人理解语言命令并适应新场景,然后在全新任务上的表现比其前身提高了一倍。两年后,Gemini Robotics似乎又取得了一次重大飞跃,包括理解应该做的行为,以及执行RT-2无法处理的复杂物理操作。

虽然RT-2仅限于重新利用它已经练习过的身体动作,但据报道,Gemini Robotics表现出显著增强的灵活性,可以完成以前不可能完成的任务,例如折纸和将零食装入Zip-loc袋中。从仅仅理解命令的机器人到可以执行精细物理任务的机器人的转变,这都表明DeepMind可能已经开始解决机器人技术的最大挑战之一:让机器人将其“知识”转化为现实世界中谨慎、精确的动作。

更好的泛化结果

据DeepMind称,与之前的AI模型相比,新的Gemini Robotics系统表现出更强的泛化能力,即能够执行未经专门训练的新任务。该公司在公告中声称,与其他最先进的视觉-语言-动作模型相比,Gemini Robotics“在综合泛化基准上的性能提高了一倍以上”。泛化很重要,因为能够适应新场景而无需针对每种情况进行专门训练的机器人有朝一日可以在不可预测的现实环境中工作。

这很重要,因为人们仍然怀疑目前的人形机器人有多大用处,或者它们到底有多大能力。特斯拉去年10月推出了Optimus Gen 3机器人,声称能够完成许多体力任务,但在该公司承认其引人注目的演示中的几个机器人是由人类远程控制后,人们仍然对其自主AI能力的真实性感到担忧。

而谷歌正试图制造真正的机器人:一个通用的机器人大脑。为了实现这一目标,该公司宣布与位于德克萨斯州奥斯汀的Apptronik合作,“用Gemini 2.0打造下一代人形机器人”。谷歌表示,虽然Gemini Robotics主要在名为ALOHA 2的双手机器人平台上进行训练,但它可以控制不同类型的机器人,从面向研究的Franka机械臂到更复杂的人形系统,如Apptronik的Apollo机器人。

安全性和限制

出于安全考虑,谷歌提到了一种“分层、整体的方法”,该方法保留了传统的机器人安全措施,例如避免碰撞和限制力量。该公司描述了受Isaac Asimov的机器人三定律(Three Laws of Robotics)启发而开发出“机器人宪法(Robot Constitution)”框架,并发布了一个名为“ASIMOV”的数据集,以帮助研究人员评估机器人动作的安全影响。

这个新的ASIMOV数据集代表了谷歌试图创建标准化方法来评估机器人的安全性,而不仅仅是预防身体伤害。该数据集似乎旨在帮助研究人员测试人工智能模型,即对机器人在各种情况下可能采取的行动的潜在后果的理解程度。根据谷歌的声明,该数据集将“帮助研究人员严格衡量机器人行动在现实场景中的安全影响。”

本文作者可以追加内容哦 !