2023年是AI大模型元年,要训练出高性能、高智能的AI模型,不仅需要大量的数据和算法,还需要强大的计算能力和硬件支持。AI芯片作为构成算力架构的基础,已成为全球科技公司竞争的焦点。

根据德勤预测,2024年AI芯片总销售额将占全球芯片市场预计规模5670亿美元的11%,其中针对AI优化的专用芯片将超过500亿美元,预计将占所有AI芯片年销售额的三分之二。

英伟达凭借其强大的H100芯片长期占据市场主导地位。今年,英伟达又将在二季度供货性能更强的H200芯片。对此,科技巨头英特尔、谷歌、Meta(原Facebook)相继推出自家AI芯片产品,意图打破英伟达的垄断局面。

以推理为突破口 英特尔能否分一杯羹?

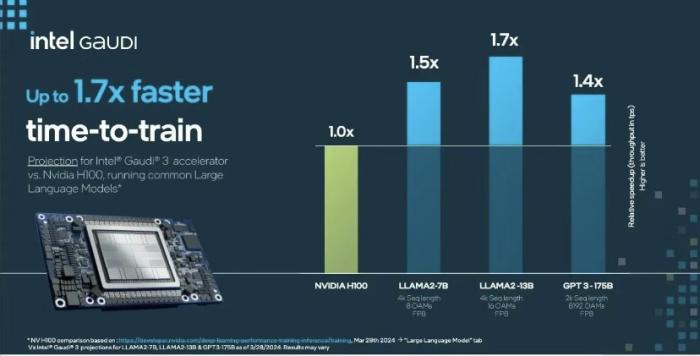

在“Intel Vison”大会上,英特尔重磅发布了新一代AI芯片Gaudi3,较英伟达H100芯片在推理性能、硬件性能、I/O性能上均有提升,CEO帕特·基辛格更是宣称与英伟达H200性能相当。

首先,Gaudi3推理能力平均提高50%,运行AI模型的速度则达到1.5倍。其次,Gaudi 3采用了台积电5nm工艺,张量核心数量增加,性能在部分大模型上超越H100。此外,提高了端口速率和端口数量,增强整体数据传输能力。

去年年底,英特尔CEO帕特·基辛格曾炮轰英伟达的CUDA生态,称其“既窄又浅”,并声称对于AI而言推理技术比训练更加重要。尽管H100已经问世2年,但如果Gaudi3成功在推理方面大幅击败H100,这对英特尔而言将是一个巨大的胜利。

然而Gaudi3真的能够比肩H100吗?当下是无法持一个明确的肯定态度。

这主要是由于,英伟达并没有止步H100。今年三月,英伟达基于BlackWell GPU(图形处理器)架构发布的B100,性能再次获得大幅提升,连马斯克都不禁感慨,“目前没有什么比英伟达GPU更好的AI芯片了。”

如果将英伟达最新款B100和英特尔Gaudi3进行对比,两者差距一目了然。

从硬件方面来看,英伟达B100采用3nm(纳米)工艺,而英特尔Gaudi3采用的是5nm工艺打造。一般而言,3nm工艺较5nm工艺芯片,集成晶体管密度更多、性能可能是后者芯片的两倍、功耗同时降低20-30%。

目前,台积电3nm晶圆量产代表了最先进的芯片集成技术,B100在芯片工艺上的选择,就已经“秒灭”Gaudi3。当然,3nm工艺芯片制造成本较高,很可能会限制B100的客户规模,仅有需要极高性能计算和AI处理能力的客户,才能负担B100的费用。预计在价格方面,Gaudi3有一定优势。

在HBM(高带宽内存)选择上,搭载128GB内存的Gaudi3没有采用最新的HBM3,而是采用了稍微有些过时的HBM2e。与HBM2e相比,HBM3不仅传输带宽更高,单颗容量也从16GB扩大至24GB,甚至32GB。

I/O(输入/输出)方面,英特尔使用以太网路线,端口速率从100GB/S提高至200GB/S,每个芯片拥有24个以太网端口,结合与英伟达BlackWell类似的双芯片设计,每张Gaudi3的以太网I/O总带宽高达8.4TB/S。

总体而言,Gaudi3的此次升级不仅算不上激进,甚至稍显保守,尽管在部分大模型上超越了H100,但仍然很难与英伟达最新的B100相抗衡。英伟达的技术与生态领先优势、高昂的芯片成本、以及快速增长的AI芯片市场等诸多因素,都注定了英特尔的赶超之路任重道远。

(图注:Gaudily3与H100推理性能对比)

(图注:Gaudi3与H100功耗对比)

芯片只租不卖 谷歌和平“去英伟达化”

在Next大会上,谷歌公布了其自研的首款基于Arm架构的CPU芯片Axion,相较于GPU它具备算力优势,能更高效地处理大量数据集,专为数据中心AI应用设计,旨在应对从广告到大数据分析的多项任务。

具体而言,Axion芯片将广泛适用于各类任务,尤其支持谷歌的搜索引擎和AI相关工作。谷歌强调,这款芯片在AI领域发挥着关键支持作用,通过高效处理海量数据并服务于数十亿用户,展现其强大实力。

下一步,谷歌计划逐步在基于Arm的云服务器用例中运用Axion,目前Datadog、Elastic、OpenX和Snap等多家公司已计划采用这款芯片。

Axion芯片是谷歌在芯片创新领域逾十年努力的延续,尤其在ChatGPT引发的AI竞赛背景下,谷歌进一步坚定执行自研芯片战略,以减少对外部供应商的依赖。

Axion AI芯片的推出,标志着谷歌开始逐渐“去英伟达化”,在减少对英伟达芯片依赖的同时,与传统合作伙伴英特尔展开竞争,并向微软和亚马逊发起挑战。不过,谷歌副总裁Amin Vahdat强调,此举旨在扩大市场而非单纯竞争。

也许出于这方面考量,Google的Axion AI芯片采取了只租不卖的业务模式,Alphabet

(谷歌重组后的“伞形公司”)子公司的客户将能够在今年晚些时候通过 Google 的云业务访问 Axion,但无法直接购买。通过不直接向客户销售,Google 避免了与其长期合作伙伴,以及主导芯片制造商——英特尔与英伟达的直接竞争,试图通过这种模式,向行业内释放积极友好信号。

(图注:谷歌Axion AI芯片)

试图破局 Meta放了个大招

另一边,为了改变英伟达一家独大的局面,Meta也在寻求破局。

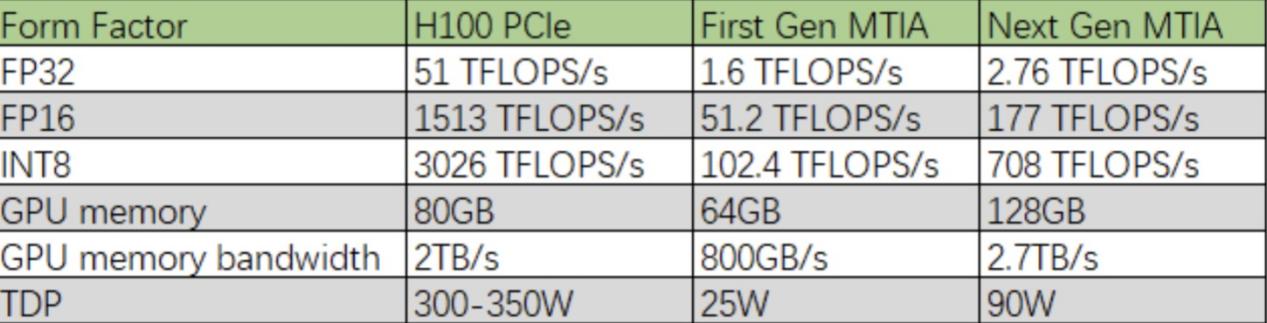

早在去年5月,Meta就已经推出首款自研 AI 芯片 MTIA(MTIA v1),采用的是台积电 7nm 制程,而最新芯片 MTIA v2 同样是交由台积电代工,制程工艺升级到了 5nm。此外,下一代 MTIA 配备更多处理核心,片内存储(on-chip memory)翻倍到了 256MB(MTIA v1 仅有 128MB),off-chip LPDDR5(第五代通信标准) 也提高到了 128GB(MTIA v1 为 64GB),主频也从 800MHz 上升到了 1.35GHz。

有意思的是,MITA v2的面积仅变大了13%,功耗却增加到上一代的3.6倍,即 90W(MTIA v1为25W)。相比之下,英伟达 H100 PCIe(高速串行计算机扩展总线标准)的最大功耗约在 350~500W 区间(SXM版高达700W),INT8(8位有符号整数)精度下稀疏算力为 3026TFLOPS(每秒浮点运算次数)。

根据Meta透露,目前MITA v2已经在16个数据中心区域投入使用。作为Meta在AI硬件领域的关键布局,MITAv2的性能提升将有效提升Meta社交软件的排名和推荐系统效率,并支持其在生成式AI领域的发展。

作为英伟达H100 GPU的重要客户,Meta预计今年底前将采购35万颗H100。与此同时,Meta正加速自研MTIA系列AI芯片,旨在减少对英伟达的依赖,降低采购成本。

随着AI技术的迅猛发展和市场竞争的加剧,在英伟达H200交付后,Meta面临重要抉择:是选择继续采购英伟达的产品以维持业务的稳定运行,还是选择自给自足,通过自主研发和技术创新来摆脱对外部供应商的依赖?

这一决策绝非易事。但从Meta近两年动作来看,Meta正加大研发投入以升级自有产品,逐步完成AI芯片的自主替代。

(图注:MTIA芯片与H100芯片对比)

面对Meta、谷歌、英特尔的纷纷亮剑,英伟达手握H100与H200,未来还有更具实力的B100等产品推出,对垒之下仍显从容。

参考资料:

《英特尔Gaudi3 AI芯片,干翻英伟达H100?》雷科技

《谷歌发布首款数据中心Arm结构处理器!》EETOP

《科技巨头接连推出《“去英伟达”AI芯片新品,这一次是Meta》硬AI

《预估2025年英伟达(NVDA.US) GB200出货量突破百万颗》集邦咨询

本文作者可以追加内容哦 !