十万块英伟达H100的训练集群你见过吗?

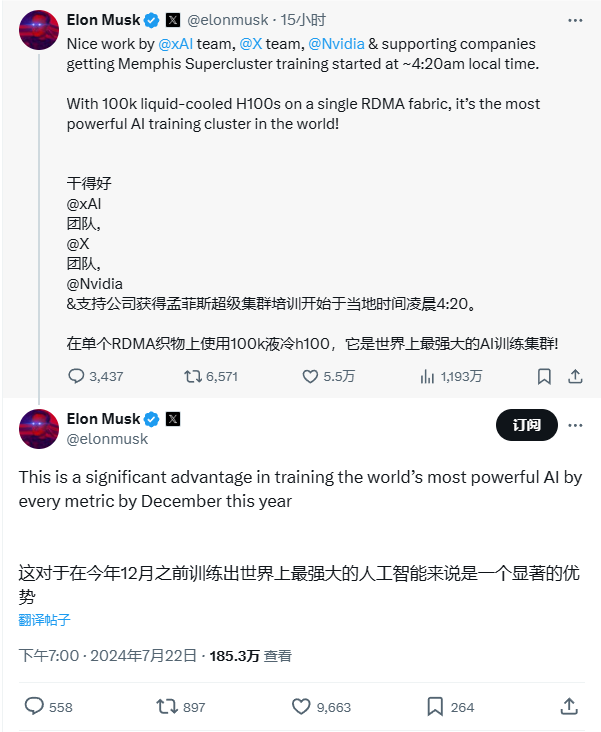

7月23日,马斯克在社交平台X上宣布,旗下xAI的专用训练集群——孟菲斯超级计算机集群(Memphis Supercluster)已经正式投入使用。

据马斯克介绍,该集群配备了10万个英伟达H100 GPU,全面超越了超级计算机Top500榜单中的任意一台,包括世界上最强的Frontier(37,888个 AMD GPU)。

该项目的启动可以追溯至今年3月。彼时,马斯克想用一个超级计算集群训练Grok3,目标是将其在年底前训练成世界上最强大的人工智能。之所以把集群放在孟菲斯建设,是因为孟菲斯作为田纳西人口第二大的城市,可以嫁接丰富的电力资源(用于运行集群)和水资源(用于散热)。

根据孟菲斯电力、天然气和水务公司的首席执行官估计,超级计算机集群每小时可能使用高达150兆瓦的电力,相当于10万户家庭所需电量,而超级计算机集群预计每天至少需要100万加仑的散热水。

最初,孟菲斯方面担心,如此大规模的资源重新分配会引起当地居民的资源短缺。作为交换,马斯克已经口头承诺将改善孟菲斯的公共基础设施,以支持数据中心的发展,包括兴建一个新的变电站和一个污水处理设施。另外,马斯克还在孟菲斯超级计算站点发布了六个招聘信息,职位包括光纤工头、网络工程师和项目经理等。

协议敲定后,今年5月,马斯克迅速开启了集群的建设工作。为此,马斯克斥巨资购买了大量英伟达“Hopper”H100 GPU,并在科技公司Supermicro订购了大量硬件。略显可惜的是,如果不是与时间抢跑,马斯克完全可以等英伟达马上推出的H200,甚至是基于Blackwell的B100和B200 GPU,如果上了这两块芯片,孟菲斯超级计算机集群的算力将不可想象。

原本在马斯克的计划中,超级计算工厂的建设完成时间为2025年秋季之前。这表明,项目完成度远超预期,提前了将近一年。马斯克表示,新的Supercluster”将“从各个方面训练世界上最强大的人工智能”,改进后的大语言模型(Grok)应该在“今年12月之前”完成训练阶段。

据了解,Grok模型是马斯克旗下xAI的生成式人工智能产品,其独特优势是可以通过X平台实时了解世界。它还可以回答大多数其他人工智能系统拒绝的尖锐问题。目前,Grok模型还是一个早期测试产品,它会在准备好之后优先向美国的X平台的Premium Plus用户提供。

本文作者可以追加内容哦 !