7月24日,芯片巨头英伟达宣布推出全新的NVIDIA AI Foundry服务和NVIDIA NIM推理微服务,这两项服务的过人之处在于,各国用户可以搭配Meta刚推出的Llama 3.1大模型,来构建符合自身需求的“超级模型”。

例如,医疗公司需要AI模型理解医学术语和医疗实践,而金融公司则需要AI模型具备金融领域的专业知识,那么上述公司就可以利用英伟达的 AI Foundry来构建“具备领域特定知识和本地化特点”的生成式AI应用。

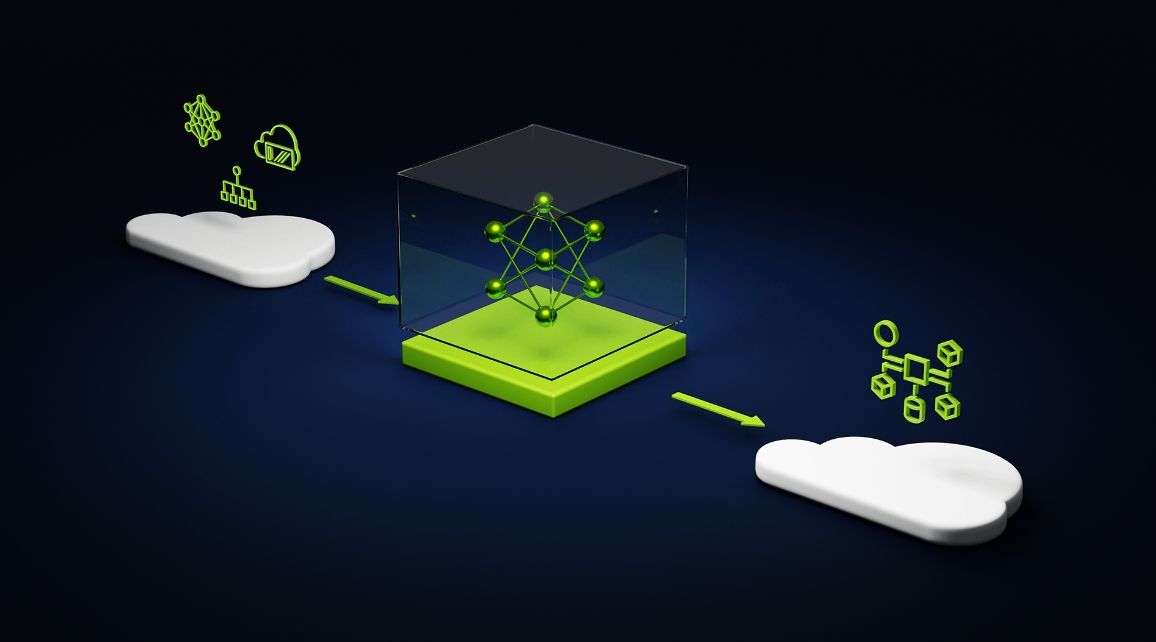

具体而言,NVIDIA AI Foundry服务由 NVIDIA DGX™ Cloud AI云平台提供支持——该平台为世界领先的公共云公司所共同设计,目的是为企业提供大量的算力支持,并可根据 AI 需求的变化轻松扩展。可以说,DGX™ Cloud AI云平台就是为了模型定制化而生。

据了解,当前的公有云基础设施的一个主要挑战是,无论是软件还是硬件都是为web时代的应用和服务构建的,无法很好地满足AI工作的需求(节点到节点、数据和用户本地性),而AI Foundry很早就意识到了生态系统的瓶颈不在于供应不足,而在于利用不足。

基于此,DGX™ Cloud AI的目标是建造一种新型的公共云,大大降低基础设施的便捷性——通过一个协调平台,使用户访问AI计算资源“像开灯一样简单”。

作为一款支持“客制化”的服务模型,英伟达在NVIDIA AI Foundry内镶嵌了如Nemotron和 Edify等原生AI模型,它们和NVIDIA NeMo™ (定制模型软件)以及NVIDIA DGX™ Cloud(提供云容量)一起,构成了AI Foundry的底盘,负责模型的基础运算架构。

至于NVIDIA NIM,它的定位则是一套加速推理微服务,可以提供适合AI Foundry运算的基础环境。在安装了NVIDIA NIM服务后,相关企业可以在云计算、数据中心、工作站和PC等任何地方的 NVIDIA GPU 上运行定制化模型。

目前,NVIDIA NIM服务对Meta刚推出的Llama 3.1大模型完全适配。数据显示,搭载了Llama 3.1的NIM推理效率要比未搭载NIM时提高2.5倍。专家称,要想获得最好的运行效果,企业可以将Llama 3.1 NIM微服务与英伟达NeMo Retriever NIM微服务结合使用,创建最先进的检索管道。

公开资料显示,Llama 3.1是Meta公司公开提供的一系列生成式AI模型。这些模型是开放源代码的,可以被企业和开发者用来构建先进的生成式AI应用。Llama 3.1模型包括80亿、700亿和4,050亿参数规模,经过超过16,000个英伟达H100 Tensor Core GPU的训练,优化后适用于数据中心、云端及本地设备。

目前,已经有一些大型公司开始采取NVIDIA AI Foundry完成自己的定制化模型,全球专业服务公司埃森哲(Accenture)就是其中之一。该公司表示,生成式AI正在改变各个行业,企业渴望部署由定制模型驱动的应用程序。借助英伟达AI Foundry,我们可以帮助客户快速创建和部署定制的Llama 3.1模型,推动变革性AI应用。

英伟达创始人兼首席执行官黄仁勋则称,Meta公开的Llama 3.1模型对于全球企业采用生成式AI是一个关键时刻。Llama 3.1为每个企业和行业开启了大门,能让它们做出最先进的生成式AI应用。英伟达AI Foundry全面融合了Llama 3.1,随时能帮企业构建和部署定制的Llama超级模型。

Llama 3.1大模型的母公司——Meta的创始人兼首席执行官扎克伯格则表示:“新的Llama 3.1模型是开源AI迈出的极其重要的一步。借助英伟达AI Foundry,公司可以轻松创建和定制人们想要的最先进的AI服务,还能通过英伟达NIM进行部署。我很高兴能把这个交到大家手中。

本文作者可以追加内容哦 !