沃尔神宇精达最,新亚也会受益

https://tech.ifeng.com/c/8cIs2OtDS7a

英伟达Blackwell在数据中心投入运行:NVLINK升级至1.4TB/s,首张FP4 GenAI图像公布

IT之家 8 月 24 日消息,英伟达邀请部分媒体举办吹风会,向科技记者首次展示了 Blackwell 平台。英伟达将出席 8 月 25-27 日举办的 Hot Chips 2024 活动,展示 Blackwell 平台在数据中心投入使用的相关情况。

否认 Blackwell 推迟上市消息

英伟达在本次吹风会上,驳斥了 Blackwell 推迟上市的消息,并分享了更多数据中心 Goliath 的相关信息。

英伟达在吹风会上演示了 Blackwell 在其一个数据中心的运行情况,并强调 Blackwell 正在按计划推进,并将于今年晚些时候向客户发货。

有消息称 Blackwell 存在某种缺陷或问题,今年无法投放市场,这种说法是站不住脚的。

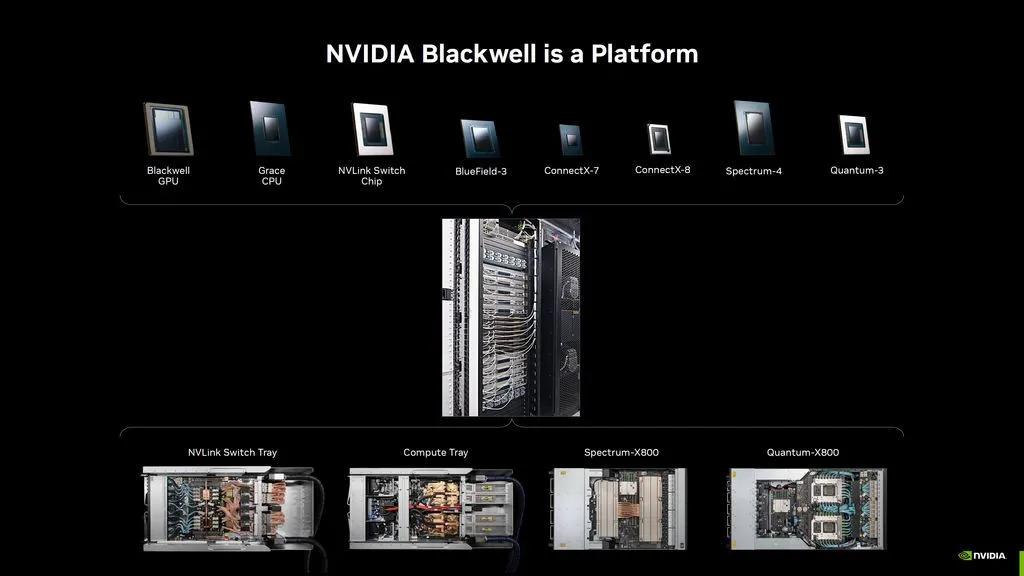

Blackwell 简介

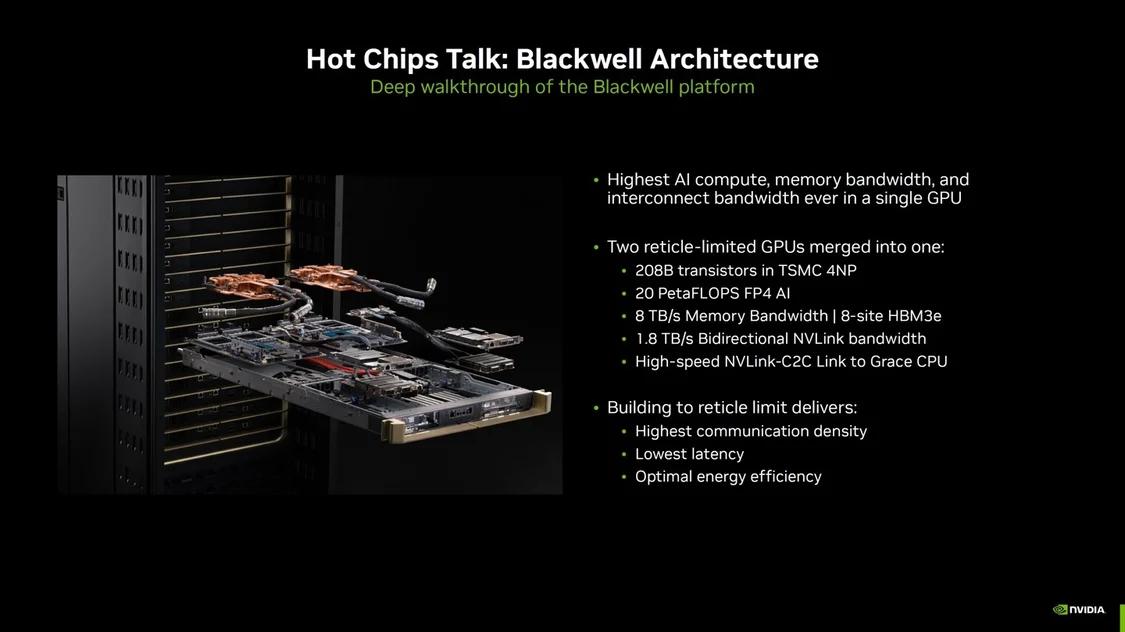

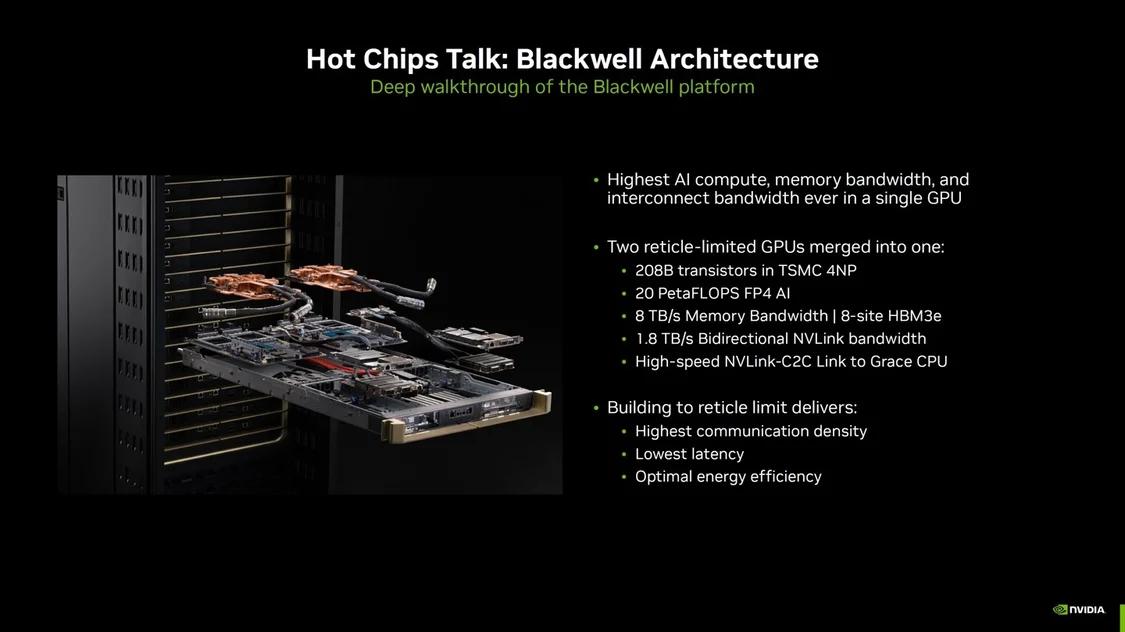

英伟达表示 Blackwell 不仅仅是一款芯片,它还是一个平台。就像 Hopper 一样,Blackwell 包含面向数据中心、云计算和人工智能客户的大量设计,每个 Blackwell 产品都由不同的芯片组成。

IT之家附上包括的芯片如下:

Blackwell GPU

Grace CPU

NVLINK Switch Chip

Bluefield-3

ConnectX-7

ConnectX-8

Spectrum-4

Quantum-3

Blackwell 桥架

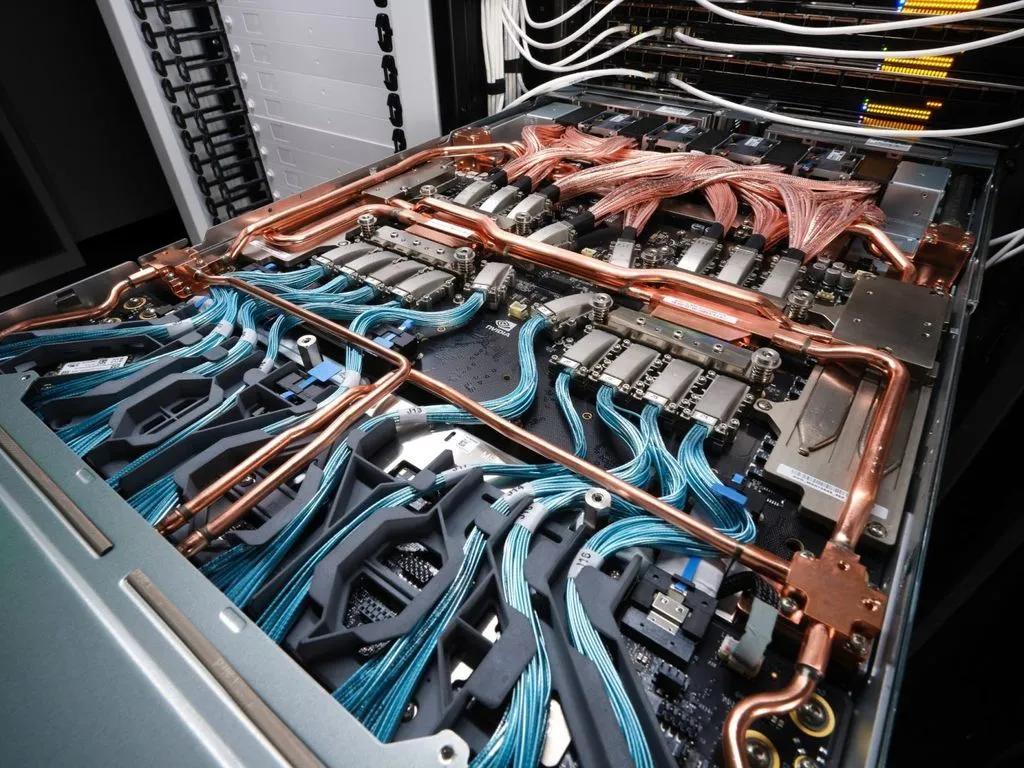

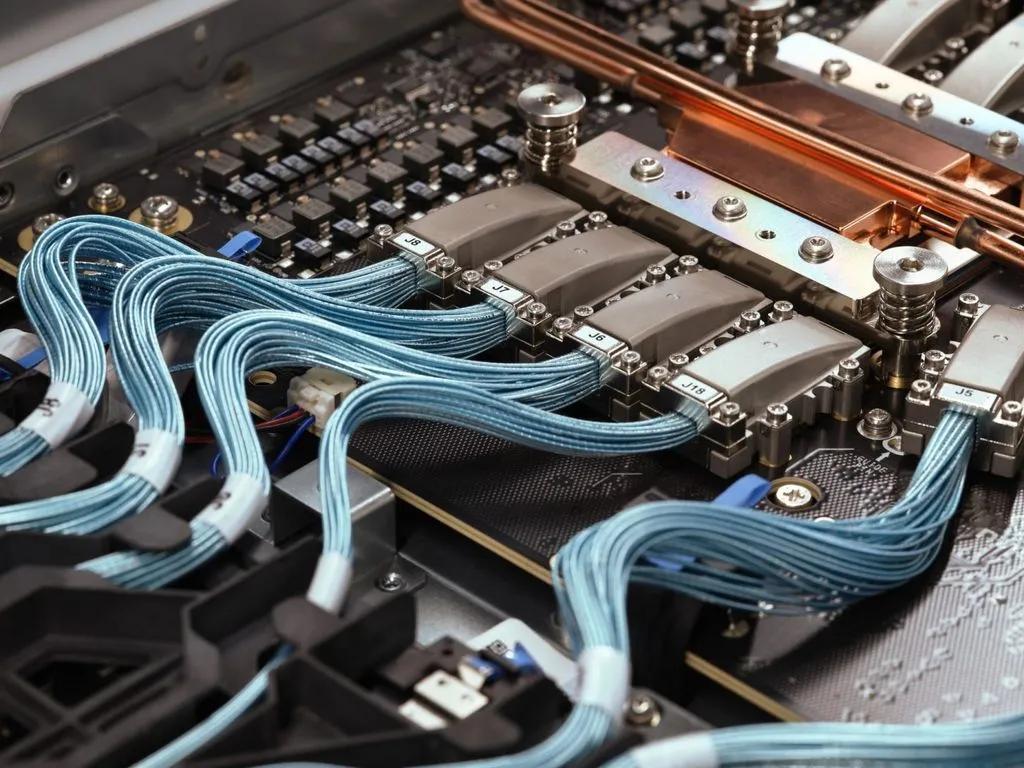

英伟达还分享了 Blackwell 系列产品中各种桥架的全新图片。这些是首次分享的 Blackwell 桥架图片,展示了设计下一代数据中心平台所需的大量专业工程技术。

目标万亿参数 AI 模型

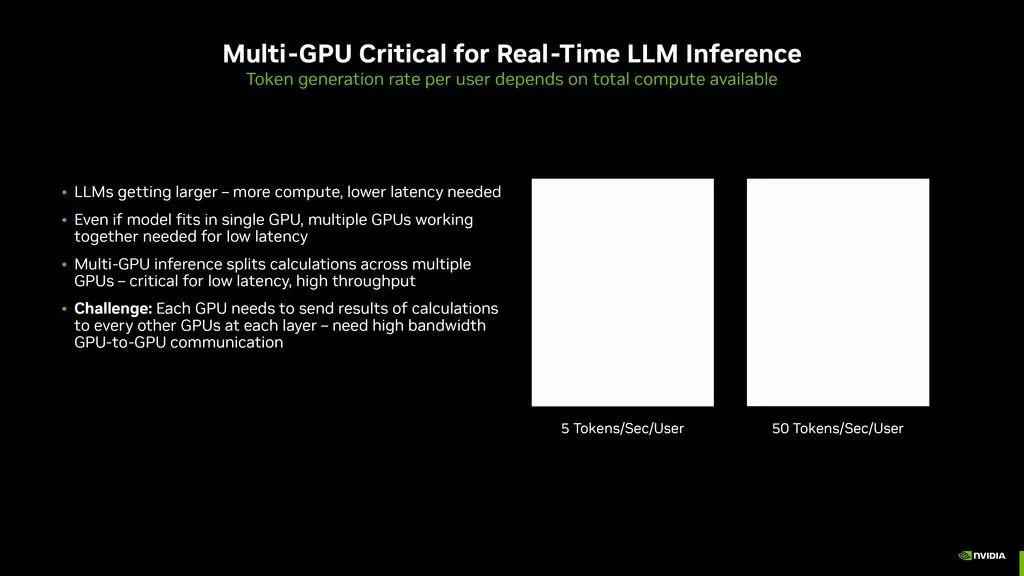

Blackwell 旨在满足现代人工智能的需求,并为大型语言模型(如 Meta 的 405B Llama-3.1)提供出色的性能。随着 LLMs 的规模越来越大,参数也越来越多,数据中心将需要更多的计算和更低的延迟。

多 GPU 推理方法

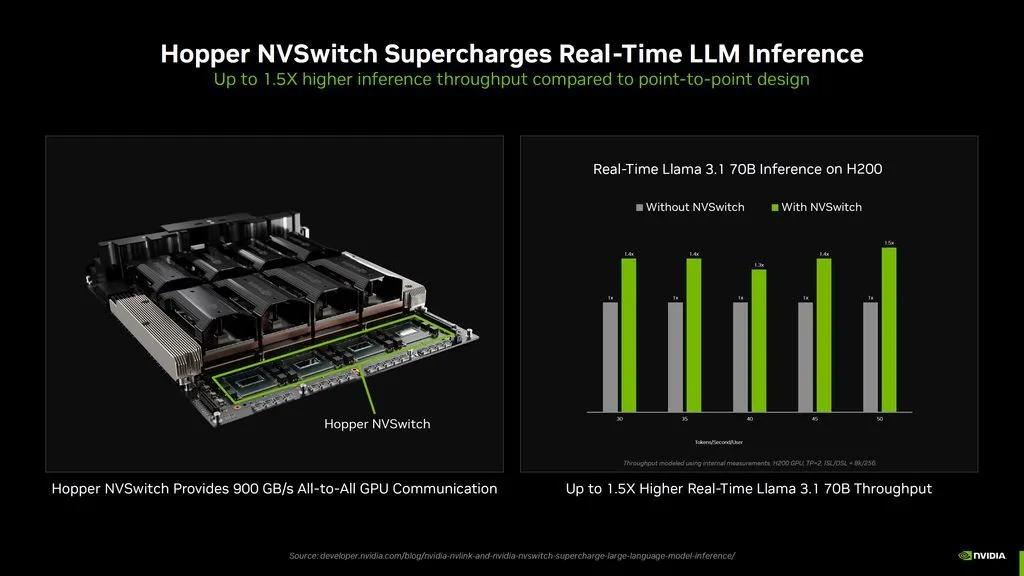

多 GPU 推理方法是在多个 GPU 上进行计算,以获得低延迟和高量,但采用多 GPU 路线也有其复杂性。多 GPU 环境中的每个 GPU 都必须将计算结果发送给每一层的其他 GPU,这就需要高带宽的 GPU 对 GPU 通信。

多 GPU 推理方法是在多个 GPU 上进行计算,以获得低延迟和高量,但采用多 GPU 路线也有其复杂性。多 GPU 环境中的每个 GPU 都必须将计算结果发送给每一层的其他 GPU,这就需要高带宽的 GPU 对 GPU 通信。

更快的 NVLINK 交换机

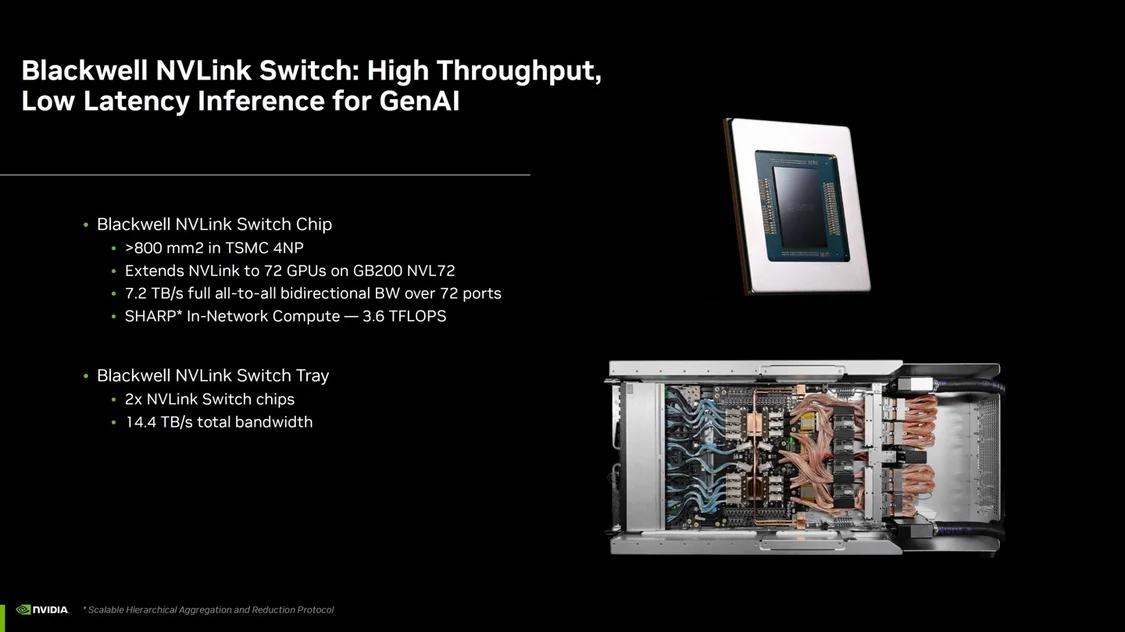

通过 Blackwell,NVIDIA 推出了速度更快的 NVLINK 交换机,将结构带宽提高了一倍,达到 1.8 TB/s。NVLINK 交换机本身是基于台积电 4NP 节点的 800mm2 芯片,可将 NVLINK 扩展到 GB200 NVL72 机架中的 72 个 GPU。

该芯片通过 72 个端口提供 7.2 TB/s 的全对全双向带宽,网内计算能力为 3.6 TFLOPs。NVLINK 交换机托盘配有两个这样的交换机,提供高达 14.4 TB/s 的总带宽。

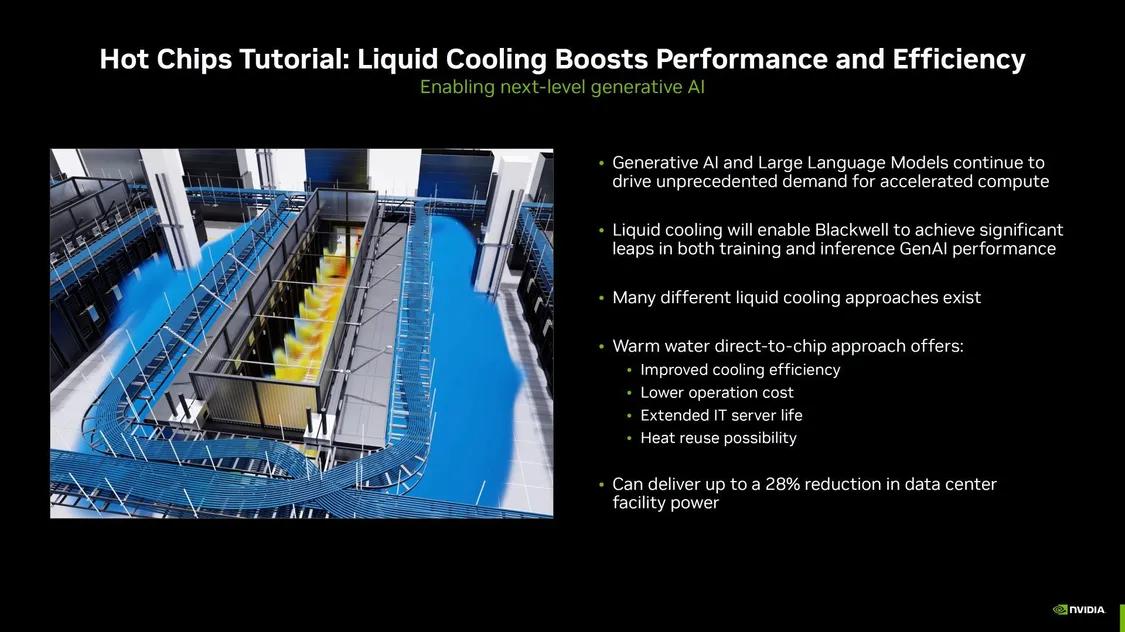

水冷散热

英伟达采用水冷散热,来提升性能和效率。GB200、Grace Blackwell GB200 和 B200 系统将采用这些新的液冷解决方案,可将数据中心设施的电力成本最多降低 28%。

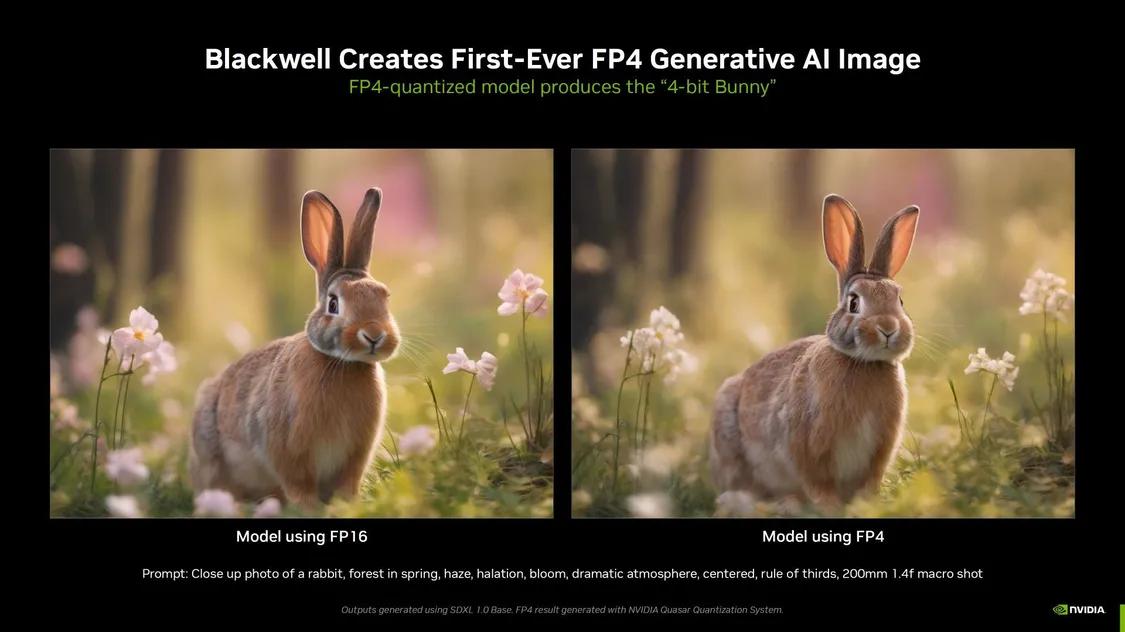

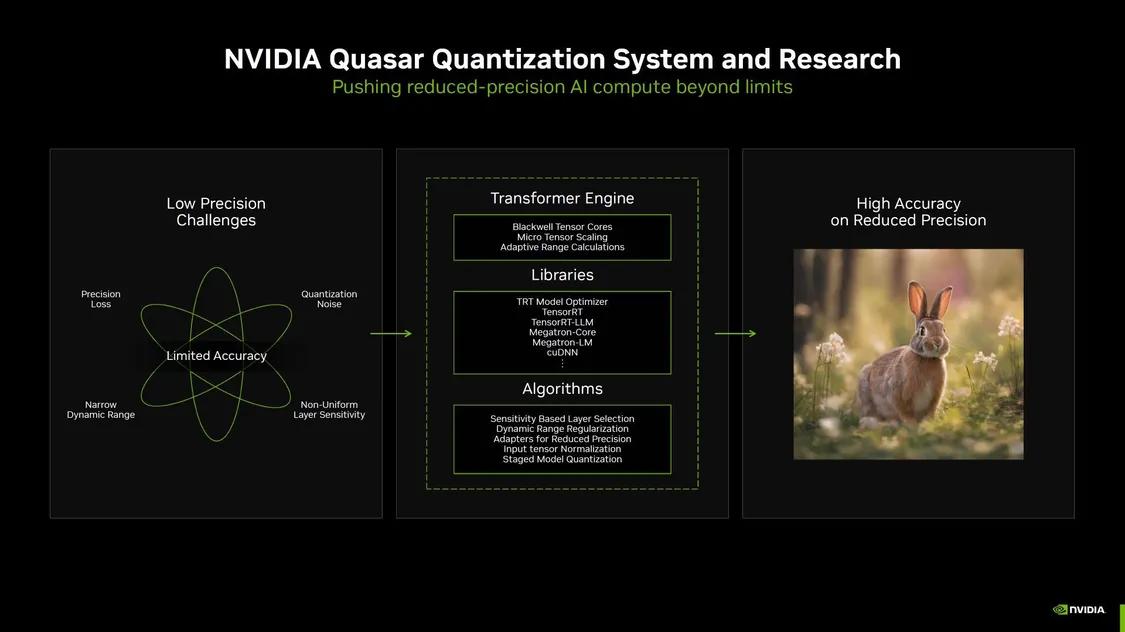

首张使用 FP4 计算生成的人工智能图像

英伟达™(NVIDIA)还分享了全球首张使用 FP4 计算生成的人工智能图像。图中显示,FP4 量化模型生成的 4 位兔子图像与 FP16 模型非常相似,但速度更快。

该图像由 MLPerf 在稳定扩散中使用 Blackwell 制作而成。现在,降低精度(从 FP16 到 FP4)所面临的挑战是会损失一些精度。

本文作者可以追加内容哦 !